Livre blanc

Consultez notre livre blancRéférencement de marque sur le web

Remerciements

Nous tenons à remercier tout particulièrement nos tuteurs, M. Ahmed BOUNEKKAR et M. Philippe-Liev POURCELOT, pour leurs conseils ainsi que pour le temps qu'ils nous ont consacrés pour nous aider dans nos recherches et dans l’élaboration des rapports.

Nous souhaitons aussi remercier M. David PASSEGAND pour nous avoir proposé et fait confiance pour ce sujet de veille technologique sur le référencement d’une marque sur le web.

Introduction

Dans le cadre de notre UE de Veille Technologique, nous avons été amenés à réaliser une veille sur le référencement d’une marque sur le web.

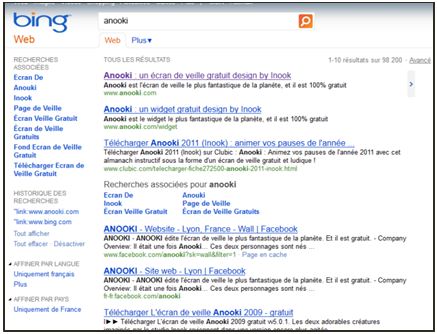

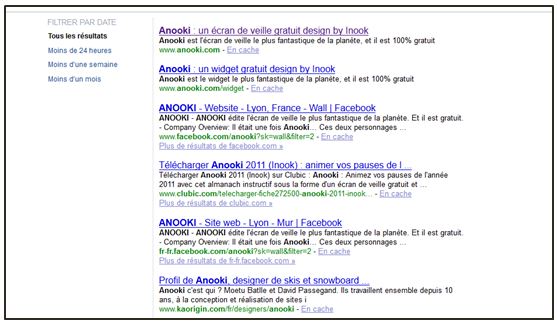

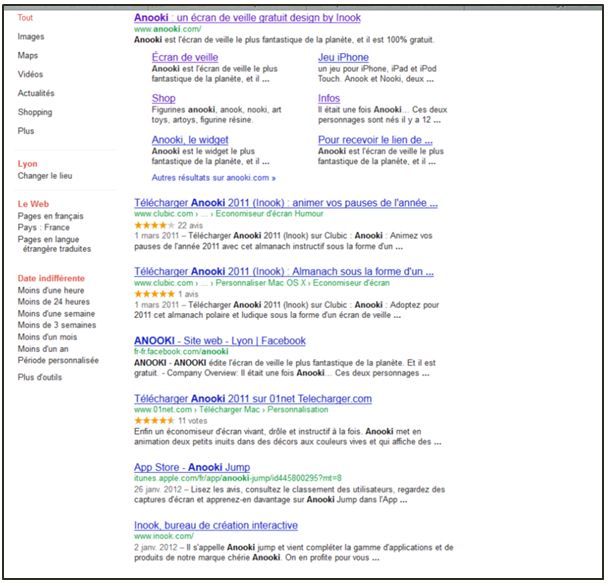

Notre commanditaire, Monsieur David PASSEGAND, voulait connaître les techniques à mettre en place pour que la marque Anooki soit bien référencée sur les différents moteurs de recherche et aussi sur les réseaux sociaux.

Dans ce livre blanc, vous trouverez en premier lieu, une présentation du groupe. Dans un deuxième temps, nous présenterons les différents axes de recherches ainsi que leurs évolutions. Ensuite nous vous apporterons une vision prospective à 6 mois, 1 an et 5 ans du référencement sur le web. Enfin nous finirons par une conclusion.

Présentation de l'équipe

Notre équipe est composée de 6 étudiants:

- Amardine DAVID

- Adrien DEPRES

- Renald MARTIN

- Robin MIZREH

- Guillaume P.

- Amaury VALLIER

Nous sommes étudiants en deuxième année d’école d’ingénieur, à Polytech Lyon, dans la filière informatique. Nous sommes encadrés par un tuteur technique, Monsieur Ahmed BOUNEKKAR et un tuteur de communication, Monsieur Philippe-Liev POURCELOT.

Tout au long de notre projet, Amardine DAVID a été notre chef de projet, il a donc été l’interlocuteur privilégié des tuteurs (technique et communication) ainsi que du commanditaire.

Adrien DEPRES a été la responsable de la gestion des connaissances, dans l’outil collaboratif et dans le forum.

Renald MARTIN a été en charge de l’aspect technique de l’outil collaboratif et du forum. Il a veillé à leurs bons fonctionnements.

Nous avons utilisé tout d’abord l’outil collaboratif Dot Project pour déposer nos différentes recherches, mais nous nous sommes rendu compte que cet outil n’est pas très pratique. Nous nous sommes donc rabattus sur deux outils beaucoup plus pratiques, le Drop box pour le partage des documents, de nos comptes rendus de réunion et des documents à rendre. Le deuxième outil est un forum, utile pour partager nos recherches. Pour ce qui est de planifier les rendez-vous, nous avons utilisé Doodle.

I. Préambule

1. Rappel historique

Voici un rapide rappel historique des différentes technologies liées au référencement d’un site web :

Commençons par l’historique des moteurs de recherche. C’est au début de l’année 1994 qu’on voit apparaître le moteur Aliweb, pour Archie LikeIndexing for the Web. Pour la petite histoire, Archie fait référence à un logiciel de l’an 1990 qui permettait à ses utilisateurs de retrouver les dossiers stockés dans leur base de données, une première jusqu’alors. Cependant, les recherches via Aliweb n’étaient faites qu’à partir d’index fournis par les webmasters, et non de manière autonome comme c’est le cas actuellement.

Il ne faudra attendre que quelques mois avant qu’Excite, un autre moteur web, apparaisse, et effectue ses recherches à partir d’analyses statistiques de mots présents au sein des pages web. Ce nouveau modèle fut le précurseur et le point de départ d’une longue série de moteurs de recherche, plus sophistiqués et proches de ceux que nous connaissons aujourd’hui.

A partir de 1994, les annuaires web commencent à être mis au-devant de la scène, et notamment grâce à Yahoo!. En cette même année, de nombreux moteurs de recherche voient le jour. Yahoo! se présente alors comme un outil de recherche alternatif, où l’humain est l’acteur majeur du bon déroulement de la recherche (cette caractéristique étant l’essence même de la distinction entre un moteur de recherche et un annuaire).

Fin 1995, Altavista devint le moteur de recherche incontournable de l’époque, puisqu’étant capable d’indexer la totalité des pages web disponibles sur la toile.

Le dernier tournant concernant les évolutions majeures des moteurs de recherche est abordé en 1998 lorsque Google voit le jour, amenant comme innovation principale dans la technologie de l’indexation le classement des résultats par popularité.

Il est à noter qu’aujourd’hui Yahoo! est passé du côté des moteurs de recherche, constat intéressant, matérialisant ainsi l’utilisation préférentielle des internautes de ce type d’outil plutôt que des annuaires web.

2. Rappel des acteurs

2.1 Les moteurs de recherche et les annuaires

Citons en premier lieu les moteurs recherche, qui sont des outils indexant les pages web des sites dans une base de données via ce qu’on appelle des robots d’indexation (bots en anglais). Ces sites web sont ensuite disponibles pour les internautes à partir de mots-clés. Mais la personne qui recherche un site ne va pas parcourir une liste : c’est le moteur de recherche qui va lui suggérer, par ordre de popularité et de pertinence, une liste de sites en lien avec sa recherche.

Parmi eux, nous trouvons Google, le moteur de recherche le plus utilisé au monde, puisque détenant pas moins des deux-tiers des parts de marché sur ces dernières années. Sur la deuxième et troisième marche du podium se positionnent Yahoo! et Bing respectivement, l’utilisation de ces derniers restants tout de même nettement inférieure à celle de Google. Bien qu’un nombre important de moteurs de recherche existent encore, ils ne seront pas cités ici puisque très peu utilisés ou alors ne rentrant pas dans le cadre de notre sujet de veille (comme Baidu par exemple).

Depuis peu, les internautes ont également à leur disposition des méta-moteurs, comme Seek. Ici, les informations de recherche données par les visiteurs sont envoyées vers plusieurs moteurs de recherche. Les pages affichées en tête de liste sont celles étant référencées par le plus grand nombre de moteurs de recherche. On voit donc l’utilité pour un site web d’être correctement référencé dans plusieurs moteurs de recherche, malgré la suprématie de Google sur le marché.

Parmi les autres acteurs du référencement qu’un site web peut exploiter, on trouve les annuaires web. Ceux-ci répertorient les sites web par intervention humaine, et non de manière automatisée comme c’est le cas pour les moteurs de recherche grâce aux robots d’indexation. Cette liste peut faire l’objet d’une spécification préalable, en fonction des centres d’intérêts des internautes. Dans ce cas, l’internaute est totalement maître de sa recherche, et n’est pas dépendant d’un algorithme, seuls les critères qu’il a indiqué vont le conduire à ce qu’il cherche.

Pour les annuaires, la présence d’un leader mondial traversant les années n’est pas avérée, et les annuaires sont de loin bien moins utilisés que les moteurs de recherche classiques. Citons toutefois quelques grands annuaires web intéressants, se voulant généralistes : IndexWeb, Top Lien, Next SEO, Infinisearch, Webrankinfo, Gralon, Waaaouh. Il existe aussi des annuaires spécialisés dans un domaine précis, auquel il peut être intéressant de prêter attention.

2.2 Les outils d'analyse

Le référencement est un sujet qui concerne les sites Web d’une manière générale. De nombreux sites et services se sont donc créés autour de cette discipline. Il y a deux types de sites à différencier : les sites d’informations, et des sites présentant des services pour le référencement. On peut éditer soi-même ses services de référencement, mais ils pourront difficilement être aussi évolués que ceux proposés par les grands acteurs du marché.

Les services fournis par les sites sont en général des outils statistiques et comportementaux. Ils analysent toutes les données des visiteurs entrants sur le site afin d’en tirer des schémas génériques sur le comportement de ces derniers. La plupart des hébergeurs fournissent, moyennant finances, des outils statistiques simples afin que les moins érudits dans le domaine du référencement aient tout de même des outils à portée de main. Ces outils se limitent généralement à la provenance du visiteur, et non pas à son comportement. Nous ne listerons pas les différents hébergeurs qui proposent ce service de statistiques, car leur nombre est beaucoup trop important, tant ce niveau d’étude est facile à mettre en place.

Il existe cependant des sites prestataires, fournissant des services dédiés aux statistiques comportementales. Parmi ces sites, on trouve quelques grands acteurs : Google Analytics, le service de Google, XiTi, le principal acteur français, et Piwik, le principal site anglophone. Nous ne traiterons pas en détail le cas Piwik ici, car il s’agit d’une Web Application, c’est-à-dire qu’il faut installer ce programme sur son serveur Web. Dans le cas de Google Analytics et XiTi, il s’agit bel et bien d’un site Web, sur lequel on retrouve les données statistiques des sites inscrits.

2.3 Les réseaux sociaux

Les réseaux sociaux tels que Facebook (900 millions d’utilisateurs dans le monde) et Twitter (500 millions d’utilisateurs dans le monde) sont des outils de partage aussi bien dans la vie privée que professionnelle. Ces outils ont également une influence sur les résultats des requêtes dans les moteurs de recherche, comme les ingénieurs de Google et Bing l’ont récemment avoué. En effet, Facebook et Twitter entrent en compte dans les algorithmes de référencement de ces moteurs de recherche. Ainsi, utiliser les réseaux sociaux augmente favorablement la popularité d’un site et influence sa position dans les résultats de recherche. En effet, pour ces deux moteurs, la notoriété sociale a un impact direct sur la popularité des pages indexées, et il est plus précisément tenu compte des liens provenant des pages fan de Facebook et des Tweets de Twitter. Ainsi, Google calcule un score de qualité et Bingun score d’autorité pour chaque utilisateur Twitter et Facebook, qu’ils intègrent dans leurs algorithmes. Ceux-ci sont évalués en fonction du nombre d’utilisateurs suivis et du nombre d’abonnés et de la notoriété de ces derniers. Ces données ont un impact sur le référencement naturel et principalement sur la recherche en temps réel.

Pour Twitter, le calcul de ces scores de qualité et d’autorité s’effectue notamment grâce au nombre d’abonnés et d’abonnements justifiant la notoriété d’un compte, mais également grâce au nombre de tweets et de retweets, au nombre de mentions, au nombre d’apparitions dans des listes. En ce qui concerne Facebook, le calcul est effectué grâce au nombre de fans, au nombre d’interventions sur le mur, au nombre de commentaires, au nombre d’annotations « Like » et à l’évolution du nombre de fans.

La présence sur les réseaux sociaux permet d’améliorer le référencement naturel. Facebook et Twitter sont donc des acteurs qui sont devenus des moyens de communication très efficaces et gratuits pour référencer une marque, des produits ou des services.

2.4 Les visiteurs

Un dernier élément essentiel pour augmenter la popularité d’un site, mais moins évident à appréhender de prime abord, la prise en compte des différents types d’utilisateurs que l’on peut trouver sur internet. Effectivement, la connaissance du comportement des différents profils d’internautes constitue un très bon outil pour adapter son site à la plus large cible possible.

Un des facteurs à maîtriser est l’hétérogénéité des nationalités et des cultures qui se côtoient parfois même au sein d’un même pays. Des études ont été réalisées sur ce sujet et montrent que chacune a des caractéristiques propres. De ce fait, il est donc très intéressant de se renseigner tout d’abord sur quel pays le site en question attire le plus d’internautes (par exemple par le biais des outils d’analyse web cités dans les parties précédentes, avec l’option localisation géographique). Ensuite, on peut déterminer au sein de chacun de ces pays si les sous-groupes sont assez importants en nombre pour qu’une offre particulière leur soit accordée.

Autre critère à prendre en compte, l’âge des internautes. Les enfants, les adolescents, les adultes, ou encore les personnes âgées ne se comportent pas de la même manière sur les sites web. Ainsi donc, la mise en place au sein du site de moyens spécifiques visant à toucher ces différentes catégories d’utilisateurs est donc loin d’être optionnelle.

Dernier critère majeur provoquant une différence de comportement entre utilisateurs, l’expérience du web. Cette variable peut être influencée par d’autres, en l’occurrence une personne du troisième âge aura plutôt tendance à avoir fréquentation d’internet optionnelle voire nulle, et ne réagira donc pas comme une personne surfant sur la toile quotidiennement, qui aura elle des habitudes préétablies. Il est par ailleurs intéressant d’avoir connaissance de telles routines, toujours dans le même but : adapter au mieux son site à tous les types d’utilisateurs.

3 Le bilan sur la situation socio-juridico-économique

3.1 L'évolution du marché

A ses débuts, le web restait très basique, et une entreprise était représentée par une simple page HTML. Composée de textes, de menus et de liens très simples, les pages des sites ne comportaient généralement qu’une simple plaquette, avec des informations pour contacter cette entreprise. La rédaction d'un contenu de qualité n'était pas recherchée en priorité car la clientèle était principalement réservée aux initiés et aux clients ayant les moyens d’avoir une connexion importante.

De plus, les utilisateurs étaient passifs et peu nombreux au vu du prix de la technologie et des limitations du temps de connexion. Son intérêt restaitdonc limité. Les entreprises souhaitaient alors seulement avoir une « présence » sur Internet, via la mise en ligne d'un site vitrine ou bien d'une page de contact, mais cela ce constituait pas une part de leur activité.

Les standards étaient quasi inexistants dans les débuts (apparition du W3C en 1994) et, lors de leur arrivée, ils n'étaient que très peu respectés car les acteurs y étaient peu nombreux.

Les sites Internet étaient réalisés par des amateurs, et les méthodes utilisées étaient artisanales et non apparentées à un travail de professionnels du web. Ainsi chacun de ces webmasters faisait selon ce qu'il pensait être le mieux et les résultats étaient très variables.

Puis vinrent les années 2000, avec des ordinateurs à des prix de plus en plus accessibles et des forfaits Internet illimités. Toujours en plein essor, le web est ainsi devenu à l’aube du troisième millénaire un véritable Eldorado.

L'arrivée d'une standardisation du web a permis aux personnes chargées du référencement d'optimiser correctement leurs balises et donc d’avoir des sites mieux référencés. C’est à cette époque qu’apparaissent les premières grandes agences web et que la concurrence commence à se créer. On observe des réalisations de sites Internet de plus en plus originales et perfectionnées.

L'apparition de divers gestionnaires de contenu (CMS en anglais) tels que Joomla, Drupal, etc., permettent la création de sites dont le contenu est administrable simplement. Ainsi, étant donné que les administrateurs publient des contenus au fur et à mesure, le site s'enrichit et est de mieux en mieux référencé dans les divers moteurs de recherche. Un CMS facilite l'indexation du contenu des moteurs étant donné que par définition, le contenu est séparé de l'environnement graphique. Les logiciels de design sont de plus en plus performants et les graphistes peuvent ainsi créer des sites très ergonomiques. Ainsi les utilisateurs apprécient mieux leur visite et sont susceptibles de créer des backlinks (lien externe) et de parler du site autour d'eux. Flash apparaît aussi dans les années 2000 mais nous ne nous intéresseront pas particulièrement à ce logiciel étant donné que les contenus dits "Flash" ne sont pas indexés correctement par les moteurs de recherche.

Actuellement, il est très important, au vu du nombre de clients potentiels, d'être présent sur le marché de l'Internet.

Les utilisateurs sont de plus en plus actifs avec le web 2.0 et les contenus de plus en plus riches. Mais le web 2.0 apporte des technologies telles que l’AJAX, or celle-ci n’est pas correctement référencée. Pour rappel, la technologie AJAX permet de recharger seulement une partie précise de la page, et ainsi ne pas avoir besoin de changer de page pour effectuer une action. Ainsi le moteur de recherche n’interprète pas le contenu correctement. Bien que cette technologie soit très ergonomique, son utilisation est source d’incompatibilités avec un référencement correct.

Internet est un marché arrivé à maturité. Lorsqu’un marché à atteint sa maturité, il faut faire une recherche d’innovation afin de dégager des marges et de faire face à la concurrence. Le marché est saturé, les entreprises ont besoin d’avoir la meilleure place dans les moteurs de recherche.

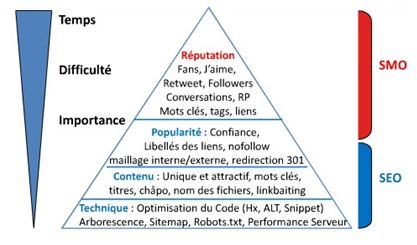

C’est ainsi qu’apparaissent de nouveaux concepts telsle SEM (SearchEngine Marketing), le SEO (SearchEngineOptimization), le SMO (Social Media Optimization) ou encore le SEA (SearchEngineAdvertising).

Les agences doivent se différencier par une plus-value et ainsi améliorer le référencement de leurs clients. C’est pourquoi référencer son site Internet devient très difficile si un site concurrent a déjà été référencé correctement.

Le marché du web est en plein essor et on constate que de nouveaux métiers mais aussi que de nouveaux standards font leur apparition. On assiste au développement de réseaux sociaux avec de plus en plus d’utilisateurs, ce qui augmente le nombre de critères à surveiller pour la bonne tenue d’un site.

3.2 Le point sur les réseaux sociaux

Avec l’arrivée des réseaux sociaux, un nouveau mot fait son apparition : le buzz. Le buzz venant du même mot anglais signifiant bourdonnement et consiste à faire du bruit autour d'un évènement, d'un produit ou d'une offre. C’est une technique de marketing permettant de promouvoir très rapidement un produit. Concernant l'aspect référencement, le buzz permet d'avoir énormément de liens pointant sur la page de votre site, attirant ainsi un maximum de visiteurs, ceux-ci en parlant activement autour d'eux, faisant augmenter les liens externes vers le site (backlinks) de manière exponentielle. Ceci fait augmenter la notoriété du site Internet (appelé aussi autorité). Ainsi les algorithmes de positionnement des moteurs de recherche considèreront le site pertinent et le positionneront avant les autres dans la liste de résultats de recherche. Ce phénomène est apparu avec le développement des réseaux sociaux, qui permettent le partage de liens à très grande échelle, et en très peu de temps.

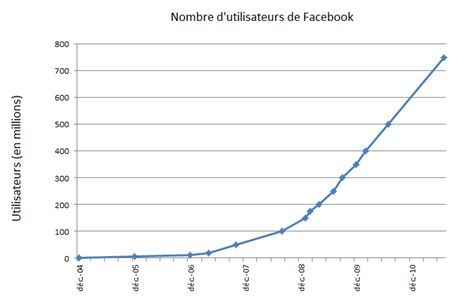

Parmi ces réseaux communautaires, on trouve Facebook, actuellement le premier réseau social au monde, en termes de volume d’utilisateurs comme de données. Populaire depuis 2005, Facebook ne cesse de croitre et les entreprises créent maintenant de manière presque systématique une page Facebook, afin de promouvoir leur entreprise ou leur marque.

Les moteurs de recherche sont également sensibles aux différentes spécificités des réseaux sociaux et indexent les pages ayant le plus de partages sur ceux-ci et non celles ayant le plus de backlinks.

On peut par ailleurs citer des réseaux communautaires comme MySpace, Google+, LinkedIn ou Viadeo qui sont eux aussi en voie d’expansion, et donc à considérer.

3.3 L'évolution juridique

Comme expliqué précédemment, une des stratégies clés pour assurer un bon référencement à son site web réside dans la collecte d’un bon nombre d’information sur les internautes visitant ce site, de manière à dresser les différents profils types des utilisateurs du site. Ces derniers sont par la suite analysés pour ajuster au mieux le site aux comportements des internautes.

Toutefois, cette récolte et cette possession d’informations personnelles par les éditeurs de site web ne peuvent se faire sans contraintes. Pour éviter litiges et abus, le code pénal à subi quelques modifications pour s’adapter à cette situation, comme l’attestent les articles 226-20, 226-21, 226-22. Dans le même ordre d’idée, la conservation de certains types d’informations ne doit pas être abusive, comme l’explique l’article 226-19.

Pour finir, il arrive que certains utilisateurs souhaitent garder l’anonymat de manière partielle ou totale : les articles 226-18 et 226-18-1 sont prévus à cet effet.

Malgré ces avertissements, il arrive fréquemment que certains éditeurs de site web passent outre. Ce qui fait l’importance de ces articles de loi, c’est le terme « déloyal », qui introduit une dimension morale. Cela donne donc lieu à des décisions de jurisprudence, et dont la source n’est pas forcément un acte illicite. Pour illustrer ces dires, citons le cas de Facebook et de ces boutons « J’aime » par exemple :

En septembre 2011, un chercheur Australien nommé NikCubrilovic, annonce qu’il a détecté des méthodes frauduleuses de la part de Facebook, qui conserve des données qu’il n’a pas le droit de conserver. Ces données sont récoltées via le Bouton « Like » et permettent à Facebook de tracer l’activité de chacun de leur membres non déconnectés ainsi que de chaque internaute qui passe sur une page ou ce bouton est présent. Facebook collecte ainsi des centaines de millions d’adresses IP, qu’il peut, si le membre en question ne s’est pas déconnecté proprement, lier à une identité présente sur le réseau social.

Face à ces révélations, un Land de l’Allemagne, a mené une étude pour voir la véracité de cette information. Aujourd’hui, le Land « Schleswig-Holstein » (Land d’Hambourg) interdit l’utilisation du bouton, par les détenteurs de site résidents dans ce Land. Bien que Facebook assure ne conserver ces données que pendant 90jours, il n’en est pas moins instructif quant au fait que si ces données tombent entre de mauvaises mains, elles permettent de tracer la totalité de l’activité de ces membres.

La vigilance est de mise quant à l’évolution de la législation à ce sujet, et tout changement impactera le référencement et la mise en avant du site.

D’autres pratiques sur le référencement sont à éviter. Ainsi la société « Saveur Bière » a été récemment condamnée à payer une amende et rendre la propriété des noms de domaines réservés. Cette société avait réalisé un « spamdexing », c'est-à-dire une réservation massive de nom afin de se positionner sur des mots clefs. Ils effectuaient une redirection vers leur site principal et donc faisaient du cyber-squatting, c’est-à-dire une occupation de l’espace Web afin d’augmenter leur visibilité sur des domaines qui ne sont pas dans leur thème.

Il n’y a pas de textes de loi vis-à-vis de ce genre de pratique, et cela relève la plupart du temps de la jurisprudence. Il faut donc rester dans une optique de légalité et surtout de ne pas « exploiter » une faiblesse d’un algorithme.

La légalité est à la frontière avec les bonnes pratiques, et ceci renforce l’importance de l’étude du Black SEO. Des pratiques qui pourraient juste paraître comme déloyales comme le spamdexing, se révèlent être traitées par la justice. Il faut s’attendre à voir évoluer dans les prochaines années la législation européenne, qui est souvent plus en avance que la législation française sur le sujet, et donc ceci peut nous permettre d’anticiper les changements au niveau de la loi française.

II. L'évolution du référencement

1. Généralités

Au début, les moteurs de recherche se concentraient uniquement sur le texte des pages. Puis petit à petit des contenus supplémentaires sont arrivés et les moteurs ont du s'adapter. Par exemple dans le référencement des images (technologie datant de 2001). Ensuite, au fur et à mesure, les moteurs de recherche ont indexé diverses informations telles que les nouveautés, les produits de sites de e-commerce, les vidéos de différentes plateformes, etc.

Depuis peu, l'évolution tends vers le web sémantique. C'est-à-dire que les moteurs de recherche interpréteront réellement les questions de l'utilisateur en affichant des résultats complets et structurés grâce à une collecte des informations sur plusieurs sites. Le moteur permettra d'approfondir la recherche en proposant de nouvelles requêtes possibles et des liens externes.

C'est pourquoi les experts en référencement doivent être constamment à l'écoute des nouveautés des moteurs de recherche et de leurs algorithmes pour rester les premiers dans les pages de résultats des moteurs (SERP : SearchEngineResult Page).

Les moteurs de recherche sont évalués par les utilisateurs sur la qualité de leurs résultats. Ainsi les algorithmes d'indexation et de résultats de page sont très sélectifs et n'hésiteront pas à supprimer certains sites de leurs résultats s'ils possèdent du contenu dupliqué ou des fermes de contenu. De plus, la sur-optimisation est pénalisée.

Aujourd'hui, les moteurs de recherche tiennent compte de l'expérience de l'utilisateur dans le classement de leurs résultats. Par exemple, si les utilisateurs repartent tout de suite du site sur lequel ils ont cliqué c'est que celui-ci ne présente pas de contenu intéressant par rapport à la recherche de l'utilisateur ou bien qu'il est trop mal présenté pour répondre aux attentes du visiteur.

C'est pourquoi, les moteurs de recherche accordent une grande partie du positionnement des résultats aux médias sociaux. C'est ce que nous allons décrire dans la partie suivante.

2. Le web social

Depuis 2005, les réseaux sociaux émergent et prennent de l’ampleur de manière exponentielle. Ils ont influencé le Web et même le monde et ont rendu l’usage d’internet plus social. Le social implique l’intervention des masses, ce qui a profondément changé la manière dont on référence un site. Les techniques de hacking et de spam sont de moins en moins efficace, et ce pour deux raisons. La première est technologique : les moteurs et les sites s’améliorent et arrivent à lutter contre le référencement black hat, celui-ci devenant plus un outil de disqualification contre l’adversaire qu’un outil de promotion. La deuxième est un effet de bord du Web social : le spam est noyé dans la masse. Twitter est un très bon exemple : il suffit regarder les tendances nationales ou mondiales, environ 10 à 20 tweets arrivent toutes les 5 secondes. Il est impossible de contrer de tels effets de masse, et c’est ce qui rend les techniques de référencement classique de moins en moins efficaces.

Ce Web participatif rend donc le référencement de plus en plus indirect, et cela se ressent dans le niveau d’activité des communautés relayant les informations sur ces segments particuliers du référencement. L’activité à soit disparu soit cela n’évolue presque plus. Le référencement s’est aujourd’hui concentré sur 2 grands acteurs : Google et les réseaux sociaux.

Facebook, Twitter, Google+, chacun de ces réseaux sociaux envahissent la toile depuis environ 7 ans. De par leur indexation particulière sur Google, les réseaux sociaux ont un impact accru sur la qualité et la solidité du référencement d’un site ou d’une marque. La participation sur ces réseaux sociaux, est aujourd’hui un élément incontournable du référencement. La puissance de phénomènes comme celui du buzz est difficilement maitrisable et affecte les moteurs de recherche de manière durable.

Les plateformes de microblogging ne sont pas non plus étrangères au phénomène de Web social. La retransmission d’information peut aussi se faire via ces centaines de types de plateformes, des plateformes comme Tumblr comptant aujourd’hui environ 45 millions de blog. La puissance du Web social grandit chaque jour, reléguant le référencement « classique » à une simple tâche initiale. Il est beaucoup plus profitable de publier des news et des données sur les réseaux sociaux et sur son site, plutôt que de chercher à créer des backlinks sur le Web.

La pluralité reste la clef et les backlinks sont nécessaires, cependant le ROI du backlinking est largement inférieur à celui des réseaux sociaux, ceux-ci nécessitant toutefois un temps non négligeable de présence.

III. Présentation des axes de veilles et leurs évolutions

1. Le black SEO

Le slogan "Don't be evil" de Google ("Ne soyez pas malveillants"), est une bonne manière d'introduire cette section dédiée à ce qu'on appelle le Black SEO (ou SEO Black Hat). Le Black SEO regroupe l'ensemble des techniques d'optimisation de référencement dites déloyales, mais pas illégales. Le référencement Web étant un sujet récent, c'est-à-dire 10 à 15 ans, la législation, que ce soit en France ou ailleurs, ne possède pas de section réellement dédiée à ce type de cas. De plus, Internet est basé sur le principe d'un accès libre, sans contrôle centralisé, ce qui empêche tout pays de légiférer par rapport à des sites situés à l'étranger.

Actuellement les seuls à pouvoir pénaliser les pratiques déloyales sont les moteurs eux-mêmes. Tous les cas de jugement prononcés ces dernières années sont pour la plupart des cas de jurisprudence. Les seuls lois existantes portent sur l'utilisation des données personnelles des utilisateurs, ce qui ne rentre généralement pas dans le cadre du Black SEO.

1.1 Le black SEO

On peut voir le SEO sous 2 aspects :

- Le SEO direct, c'est l'optimisation de son propre référencement, en utilisant diverses techniques.

- Le SEO indirect, c'est une action qui porte sur les concurrents cherchant à se référencer sur les mêmes termes.

Le SEO Black Hat joue sur ces aspects en combinant différentes techniques qui impactent le référencement d'un site. On peut directement agir sur le site en question, en réalisant des intrusions, mais ce cas-là sort du cadre du référencement Black Hat qui n'a pas vocation à réaliser des attaques virtuelles directes.

Nous allons donc voir les différentes techniques qui peuvent affecter le référencement d'un site, en commençant par les techniques indirectes, car celles-ci sont peut être pratiquées par vos concurrents.

1.2 Techniques indirectes

1.2.1 Blacklisting

1.2.1.1 La techniqueLa première des techniques, la plus simple et la plus frontale, consiste à tenter de référencer votre concurrent sur des annuaires que les autres moteurs considèrent comme "frauduleux". Google par exemple, possède un ensemble de moteurs de recherche et d'annuaires qu'il considère comme illégaux ou contenant des liens vers des sites illégaux.

Ces moteurs et annuaires sont donc passés en revue de manière régulière et si votre site se trouve dedans, il sera automatiquement blacklisté, ou verra son PageRank chuter. Généralement, cette technique ne fonctionne pas longtemps pour plusieurs raisons. Il suffit donc d'ajouter le site de son concurrent dans un nombre important d'annuaires blacklisté pour espérer que les moteurs le repèrent et le blacklistent.

1.2.1.1 Comment contrer cette techniqueTout d'abord, il est rarement question de moteur de recherche, mais plutôt d'annuaires, car le nombre de sites à référencer est faible. L'indexation des sites se fait donc de manière manuelle, et des vérifications sont effectuées quant à la qualité des liens. Celui-ci apparaitra donc rapidement comme hors-contexte et sera supprimé par l'annuaire lui-même.

Il existe bien entendu des procédures de contestations auprès des moteurs de recherche comme Google ou Bing, mais celles-ci sont un peu longues. Cependant l'effet sera vite annulé, et votre site retrouvera son PageRank d'avant, dès la levée du blacklisting. Ce n'est donc qu'une méthode temporaire si le site n'a rien d'illégal ou en dehors de la politique "morale" du moteur de recherche dans lequel vous êtes référencé.

1.2.1.1 Comment se protégerOn ne peut pas se protéger de cette technique, de par sa nature totalement extérieure, même si son effet est limité dans le temps. Cependant, si ce blacklisting intervient à un "mauvais moment", comme pour le lancement d'un produit, ou un évènement spécial, il se peut que votre communication en soit grandement affectée.

1.2.1 Le link-spamming

1.2.2.1 La techniqueUne technique qui peut être employée contre vous est le spam de votre url associé sur des forums, des blogs ou autres emplacements communautaires dans le but de vous discréditer. La personne souhaitant faire chuter le PageRank de votre site va alors utiliser des bots pour spammer la toile de liens pointant sur votre site. Les backlinks sont une bonne chose, mais comme pour toute chose, il faut que cela soit bien placé et correctement utilisé, sinon cela jouera en votre défaveur.

Pour ce qui est de la technique, elle est quasiment imparable. La première barrière que sont les captcha anti-bot à l'inscription, sont décodés moyennant finance par des sociétés basées en Asie, qui sont rémunérées pour chaque captcha résolue. Des milliers de comptes sont donc créés chaque jour afin d'augmenter cette capacité de spam. La personne souhaitant spammer n'a plus qu'à acheter une sorte de forfait. Le prix est très variable comme pour toute chose illégale, mais plus les réseaux sont divers et surtout bien référencés, plus ce spam aura de la "valeur".

Employée contre vous, cette technique affectera donc votre PageRank, et le fera chuter (si le spamming est bien réalisé).

1.2.2.2 Comment contrer cette techniquePour contrer le spamming, il n'y a pas beaucoup de choses à faire. Le principe est que l'algorithme des moteurs de recherche va pondérer la valeur des liens qui pointent sur votre site. Si les liens créés au préalable pour votre marque ont été efficacement répartis, ceux-ci auront plus de valeur. La méthode pour contrer le spam de lien doit être anticipée, et non une réaction.

Donc en théorie, il n'y a pas besoin de contrer directement cette technique car soit la protection est efficace, soit elle ne l'est pas. Si elle ne l'est pas, il suffira de renforcer cette protection et, dans le cas où la source du spam est identifiée, dénoncer l'initiateur du spam auprès de Google ou de Bing.

1.2.2.3 Comment se protégerPour se protéger de ce type d'attaques, il faut posséder un réseau fiable et solide de backlinks pointant vers le site à référencer. Si la protection est suffisante, il sera difficile d'avoir un impact sur le PageRank de votre site. Ce type d'attaques placées sur un site tel que Deezer (pour prendre un gros site), n'affectera en rien sa position dans Google ou Bing, car sa position sur le Web est assurée par des centaines de milliers de backlinks de plutôt bonne qualité.

Au-delà d'un certain stade, le référencement naturel du site, empêchera toute technique de cet ordre de fonctionner.

1.3 Techniques directes

Les techniques directes sont les plus nombreuses et les plus diverses. Le propre des techniques indirectes, est de pouvoir nuire à son concurrent. Ceci est impossible avec des techniques directes, qui ont souvent plus pour but de tromper les moteurs de recherche, et de détourner leur fonctionnement. Leur utilisation peut conduire à un blacklistage du site en cas de rupture des clauses d'utilisation des moteurs de recherche.

Il existe de très nombreuses techniques, certaines plus "déloyales" que d'autres. Vous pouvez décider d'employer certaines de ces techniques, ou bien vérifier si vos concurrents n'usent pas de ces techniques pour être mieux référencés. Si celles-ci mettent à mal votre PageRank de manière déloyale, vous pouvez choisir de signaler au moteur une utilisation de techniques interdites parmi celles que nous allons décrire.

1.3.1 Le word-wrapping

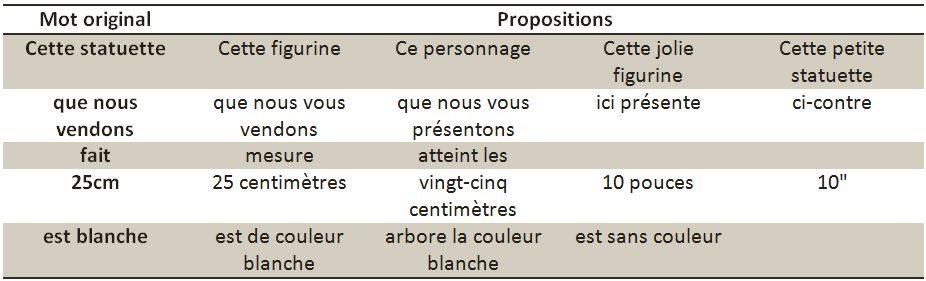

1.3.1.1 La techniqueLa technique du word-wrapping consiste à intervertir des mots ou des expressions dans un texte, dans le but de générer un contenu différent à chaque visite. Pour ce thème, un exemple est beaucoup plus approprié :

Prenons la phrase :

Cette statuette que nous vendons fait 25 cm et est blanche.

Ajoutons ensuite des expressions à wrapper, en établissant des listes d'équivalence :

Avec ce tableau d'équivalence, il suffit de prendre au hasard un ensemble par ligne pour construire la phrase :

Cette jolie figurine ci-contre atteint les 25 centimètres et est de couleur blanche.

On peut ainsi faire un nombre important de combinaisons. Pour l'exemple ci-contre, on peut réaliser 5x5x3x5x4 phrases différentes, soit 1500 combinaisons !!

D'un point de vue pratique, on ne rentre pas les possibilités dans un tableau, mais on construit une phrase avec des permutations, comme ceci :

{ Cette statuette | Cette figurine | Ce personnage | Cette jolie figurine | Cette petite statuette }

{ } représente un élément obligatoire.| représente une permutation possible.

On peut bien entendu imbriquer les accolades les unes dans les autres de cette manière :

{Cette{jolie | petite}{statuette | figurine}| Ce personnage}

On se rapproche ici une discipline bien connue des mathématiciens, qui se nomme la théorie du langage. Selon les langues, la discipline est plus ou moins ardue, et malheureusement la complexité de la langue française ne facilite pas la mise en place de tels systèmes. En revanche, la langue de Shakespeare est plus permissive et permet plus aisément de mettre en place ces systèmes.

Pour éviter la détection de ce mécanisme, il vaut mieux utiliser un système qui modifie la page à intervalles fixes, par exemple d'une heure, plutôt que d'utiliser l'aléatoire.

1.3.1.2 L'apportL'apport de ce type de pratique est plutôt faible, car les moteurs n'ont plus le même comportement. De plus les backlinks ont plus d'influence et la mise à jour de la page prévaut sur la modification pure et dure de la page.

Les moteurs repèrent aussi assez facilement ce genre de pratiques, et peuvent vous pénaliser. Il leur suffit de générer 2 fois de suite la page. Si celle-ci est différente, c'est que vous faites du word-wrapping. L'utilisation de la méthode précédemment citée permet de masquer légèrement l'utilisation de la technique, mais vous n'êtes pas pour autant à l'abri.

1.3.1.3 Observer la concurrencePour voir si cette technique est en place, il suffit d'aller une page contenant du texte chez un concurrent, et de vérifier si le texte change en rafraîchissant la page quelques temps après.

1.3.2 Le scrapping

1.3.2.1 La techniqueContrairement aux autres, ce type de pratique n'a pas d'impact direct, mais elle sert à alimenter d'autres méthodes, comme par exemple la génération de contenu.

Le principe est "d’aspirer" le contenu d'une page web, pour en extraire le contenu, via des scripts ou autre. C'est ainsi que fonctionnent la plupart des sites de comparaisons : ils analysent une page Web (souvent XML) et extraient les données. Cependant ces sites utilisent des flux XML publics, fournis par les sites, et exploitent rarement le contenu direct des pages.

1.3.2.2 L'apportL'apport direct est tout simplement nul. Il n'y a aucun intérêt à utiliser cette méthode seule, et elle n'a pour but que d'être couplée avec une autre méthode.

1.3.2.3 Observer la concurrenceIl est presque impossible de détecter que c'est une machine et non pas un humain qui visite votre site. A moins de connaitre l'adresse IP de la machine qui vous surveille et exploite vos données, sous réserve que son IP ne change pas, vous ne pouvez rien savoir, et encore moins agir.

1.3.3 La génération de contenu

1.3.3.1 La techniqueCette méthode consiste à générer des articles ou du texte de manière répétée, afin d'entretenir de manière fictive l'activité du site. La génération peut se faire de manière aléatoire, en créant des articles qui se répètent ou reprennent d'anciens articles, ou via des mises à jour qui rééditent le contenu.

Une autre solution consiste à générer du contenu à partir de sites extérieurs. Il suffit d'analyser la page de certains sites et de copier le contenu des articles. En ayant des algorithmes qui remplacent des mots par des autres, on peut arriver à faire un article neuf sans pour autant créer du vrai contenu. Cette méthode utilise donc 2 autres méthodes : le word-wrapping, et le scrapping, vues précédemment.

On peut ainsi créer des articles, des news, des flux RSS, et cela, de manière totalement automatisée.

1.3.3.2 L'apport et la concurrenceDans le cadre du référencement d'une marque et donc d'un magasin, la génération de contenu automatique n'a pratiquement aucun intérêt. Et n'a pas non plus d'intérêt pour la concurrence car il n'y a pas de contenu à extraire.

1.3.4 Le cloaking

1.3.4.1 La techniqueLe terme cloaking vient de l'anglais « cloak » qui signifie « cape » ou « couverture », ce qui évoque particulièrement bien le but de cette technique. Le principe est d'analyser l'IP du visiteur, et de changer le contenu de la page dans certains cas.

En l'occurrence, si le visiteur est un bot de Google ou de Bing, celui-ci recevra une page différente, parfaitement construite pour un référencement optimal. En revanche, si c'est un visiteur classique, celui-ci sera confronté à la page habituelle du site, qui pourra être complètement différente.

La première barrière est de pouvoir identifier la machine comme étant un bot Google ou Bing ou d'un autre moteur. C'est ce qui constitue la partie la plus difficile de la technique.

Une première méthode peut résider dans l'utilisation de cookie, mais celle-ci n'est pas fiable. Une seconde peut résider dans l'analyse de l'IP, mais encore une fois, cela demande un travail en amont conséquent.

Enfin la dernière méthode qui reste, est d'analyser l'interaction de la personne avec le site (déplacement de la souris, touches de claviers appuyées, temps passé, etc.) via l'utilisation de scriptsJavascript. Cette méthode tient un peu du Big Brother, mais elle est globalement la plus fiable. Cependant, mettre en place ce genre de mécanisme est assez lourd.

Résumons donc, il existe 3 méthodes de cloaking :

- Cloaking par IP

- Cloaking par Cookie

- Cloaking via JavaScript

Le "cloaking" est la pratique qui consiste à présenter aux utilisateurs des URL ou un contenu différents de ceux destinés aux moteurs de recherche. En raison de la présentation de résultats différents selon le user-agent, votre site peut être considéré comme trompeur et être retiré de l'index Google.

[Source : Google]

1.3.4.2 L'apportUn site marchand est généralement construit via l'utilisation d'un framework type Symfony, qui crée des structures de pages très complexes et rendent le référencement des produits compliqué. Le cloaking peut apporter une clarté et un référencement amélioré de la page.

Cependant, de par l'utilisation d'un framework, et de par le fait que Google et Bing améliorent chaque jour la détection du cloaking, il est fortement déconseillé d'utiliser ce genre de mécanismes. Même si ceux-ci sont très productifs, ils peuvent conduire à un blacklisting, car la méthode est considéré comme "intrusive" car elle a pour but de tromper, et non pas d'exploiter les failles d'un algorithme.

1.3.4.3 Observer la concurrenceIl n'est, en théorie, pas possible de voir si votre concurrent fait du cloaking. En effet, si celui-ci est bien réalisé, vous verrez la page habituelle. Cependant si celui-ci est basé sur des cookies, il est possible que vous puissiez repérer sa présence.

1.3.5 Le spamdexing

1.3.5.1 La techniqueLe principe ici est plutôt simple : il "suffit" d'acheter de grosses quantité de noms de domaines se reliant ou contenant les mots-clés sur lesquels vous voulez être référencés, et faire des redirections avec les fichiers .htaccess et non pas avec du code PHP. Avant même d'obtenir une page, les moteurs (ainsi que les visiteurs) arriveront sur votre page alors que l'url n'est pas la même.

L'url étant un critère important de référencement, vous récolterez donc les fruits du référencement de cette url dans les moteurs.

L'utilité réside principalement dans l'achat de lien pointant sur votre concurrent, notamment en achetant différentes extension comme .net, .com, .info ou encore .co. Dans le cas d'Anooki, l'url http://www.anooki.net ne renvoie sur aucun site. Un concurrent pourrait très bien acheter ce nom de domaine et s'en servir pour rediriger le trafic vers son site.

1.3.5.2 L'apportL'apport est plutôt important, dans le sens ou l'url permet de bien identifier, que ce soit par le bot ou l'utilisateur, le contenu du site. Tant que les domaines restent dans le cadre du site, il n'y a pas de côté« black hat » à proprement parler. Cependant, si vous commencez à occuper l'espace de nom de vos concurrents, ou des domaines qui n'ont pas de lien avec votre marque, vous serez confronté en premier lieu à la justice.

En effet, la société "Saveur Bière" a réalisé un spamdexing resté célèbre, bien que limité à une dizaine de domaines. Cependant, ceux-ci étaient totalement en dehors du champ autorisé. La justice n'a pas retiré tous les domaines de la marque, qui en possède encore des dizaines, mais les sommes versées ont été importantes, de l'ordre de plusieurs dizaine de milliers d'euros, pour "concurrence déloyale".

Cependant Google n'avait pas réagi malgré le fait qu'ils interdisent ces techniques :

Pages satellites ("doorway")

Les pages satellites sont généralement de vastes ensembles de pages de qualité médiocre, (…) écrites pour classer une expression particulière, puis canaliser les utilisateurs vers une destination unique.

(...) Par ailleurs, elles sont contraires à nos consignes aux webmasters.

(...) Google peut prendre des mesures à l'encontre des pages satellites et des sites qui utilisent ces pratiques trompeuses, notamment en retirant ces sites de l'index Google.

[Source : Google]

1.3.5.3 La concurrenceOn peut se rendre compte de plusieurs manières que l'espace de nom autour de son site est occupé. Premièrement, vous serez alerté par une baisse de votre PageRank, ce qui vous mènera à vérifier par exemple auprès de société permettant de réserver des domaines, quels sont les domaines libre. Si certaines extensions sont achetées et ne correspondent pas aux votre, grâce au service Whois (« Whois? », c'est-à-dire « Qui est-ce ? ») fourni par l'AFNIC (Association Française pour le Nommage Internet en Coopération).

Ensuite vous pouvez utiliser des outils de visualisation de lien durs entre sites, tels que TouchGraph SEO Brower, développé par la société TouchGraph.

1.3.6 Le misspelling

1.3.6.1 La techniqueElle consiste en l'exploitation des fautes d'orthographe ou de frappe que l'utilisateur peut potentiellement faire. Par exemple, en voulant taper « Design », l'utilisateur ira peut-être un peu vite et tapera « Deisgn », mot n'ayant aucune signification particulière, mais qui sera associé au mot-clé « Design ». Ainsi on pourra utiliser différentes techniques telles que le spamdexing (dans une optique non-déloyale), ou encore en référençant des mots clefs mal orthographiés qui seront peu utilisés par la concurrence.

Recherche du terme "Deisgn" sur Google

Le premier apport est l'augmentation du PageRank, sans devoir dépenser des sommes astronomiques pour des mots connus et communs. Certes ce n'est pas aussi efficace, mais c'est une manière comme une autre d'occuper l'espace Web, sans pour autant faire du spam.

1.3.6.3 La concurrenceLa concurrence peut très bien décider de se référencer en partie de cette manière, mais il ne s'agit pas là d'une "attaque", juste d'un positionnement stratégique. A part effectuer un référencement similaire plus efficace, rien ne peut l’en empêcher.

2. Google

En France, Google représente 90% du part de marché et plus de 67% dans le monde soit le moteur de recherche le plus utilisé. Google est donc un acteur essentiel du référencement. La manière dont leurs algorithmes vont traiter les sites est une information clé à avoir pour être bien référencé. Nous allons découper cet axe de recherche en plusieurs points. Tout d'abord nous allons examiner les critèresin-page et off-page d'un site internet, puis nous ferons un bilan sur les services Google, enfin nous nous pencherons sur Google Panda, le dernier algorithme de référencement de Google.

2.1 Critères "in-page" et "off-page"

2.1.1 Critères "in-page"

Un critère « in page » est ce que Google et les moteurs de recherche en général vont analyser sur le code HTML de votre page Internet. Le contenu de votre site est capital, mais un très bon contenu n’est pas suffisant pour le succès d’un site Internet, il faut aussi un bon référencement pour que les internautes puissent trouver votre site et donc se rendre compte de son excellent contenu. Le référencement est fait pour attirer des internautes sur vos pages, mais c’est votre contenu qui les fera rester. Nous allons maintenant nous pencher sur l’optimisation de votre code HTML pour un référencement optimal.

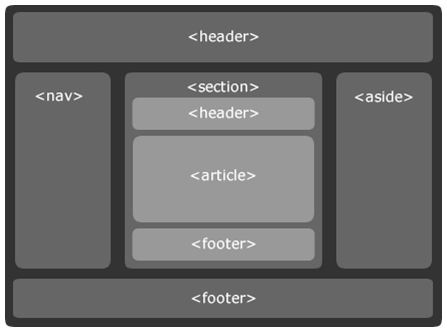

Une fois que vos mots-clés ont bien été choisis il faut donc savoir où les positionner dans votre site. Nous appelons cela les zones chaudes. Nous allons maintenant montrer où se situent ces zones chaudes au sein de votre code, il en existe 5 :

- Le premier endroit essentiel est la balise titre. Il est important d’éviter les termes génériques sur cette balise (bienvenue, homepage, …). Cette balise doit contenir le plus de mots clés possible (entre 5 et 10 termes). Le titre de votre page d’accueil doit au moins contenir le nom de votre entreprise et décrire en quelques mots son activité. Il est aussi très important que la balise titre ne soit pas la même pour chaque page du site Internet, chaque page doit avoir sa balise décrivant l’activité dont la page parle.Il faut proscrire les titres multilingues et ne pas oublier que chaque page est considérée comme un document à part entière pour les moteurs de recherche.

- Le titre ne suffit pas pour un bon référencement, il faut savoir que les moteurs de recherche regardent également ce que nous appelons le texte visible de la page. Les images et le texte sur des images ou des vidéo n’est pas pris en compte. Il est donc important que le texte de chaque page soit pertinent et cohérent avec les mots clés choisis précédemment. Le fait est qu’un moteur de recherche va utiliser des robots pour analyser le contenu de vos pages. Ces robots ne se préoccupent que du texte. Pour résumer il faut soigner les première phrases des premiers paragraphes, faire des pages à thème unique avec au moins 100 à 200 mots descriptifs. Il ne faut pas oublier de mettre en relief les mots clés important de vos pages. L’ordre et la proximité des mots au sein du texte est également important.

- La troisième zone se situe dans l’URL : il est tout d’abord important que le domaine acheté soit propre, c'est-à-dire sans redirection. Il peut être judicieux de reprendre en fin d’URL la balise de titre h1. Il faut insérer les mots clés important dans l’URL en séparant les mots par des tirets. Pour que votre site soit indexé par Google News par exemple il faut penser à ajouter des dates dans l’URL.

- Pour la quatrième zone, il s’agit des balises méta. La balise méta de description doit être unique pour chaque page. Cette balise doit développer le titre et le texte de la page. Sa taille est d’environ 200 caractères. La deuxième balise méta est le mot-clé. Elle est moins importante aujourd’hui car si elle est prise en compte par les moteurs de recherche, elle reste facultative. Avec la balise méta robots il n’y a que ces trois balises qui ont un impact sur le référencement de la page.

- Enfin l’attribut alt représente la dernière zone chaude. Il permet d’ajouter une description à une image qui s’affichera au cas où l’image ne soit pas chargée correctement. Il faut cependant savoir que l’attribut alt n’est pris en compte que par Google ; Bing et Yahoo ne la prennent pas en compte.

2.1.2 Critères "off-page"

Dans cette section, nous allons principalement traiter de l’importance des liens sur votre site Internet. Il faut savoir que l’optimisation d’un lien est important à la fois pour la page où il apparaît ainsi que pour la page vers laquelle il pointe. Il est important que le texte du lien soit en rapport avec la page cible. Les moteurs de recherche, tel que Google, s'en servent pour évaluer le référencement d’un site. Ils vont analyser ces liens à l’aide de robots (spiders), il est primordial que les liens soient facilement analysables par ces robots. C’est pourquoi on va surtout privilégier les liens textuels aux liens mis sur des images.

Aujourd’hui les principaux moteurs de recherche vont évaluer les pages à l’aide d’un indice de popularité. Pour Google il s’agit du PageRank. Cet indice va être calculé en fonction du nombre de liens pointant sur votre page : plus le lien pointant sur votre page provient d’une page avec un Pagerank élevé plus cela va influer sur le PageRank de votre page. C’est pourquoi il est crucial que les liens au sein de votre site partent des pages avec le PageRank le plus élevé pour aller vers les pages de votre site ayant un PageRank plus faible, afin de tirer ces pages-là vers le haut. Si un site web possède des liens vers un nom de domaine dans son secteur d’activité et que ce site a aussi un bon PageRank, vous gagnerez encore dans le placement de votre site. Il est aussi important que le texte du lien soit une brève description de ce que l’on peut trouver dans la page.

Afin d’augmenter l’indice de popularité de vos pages, il est important de bien choisir les pages qui vont pointer vers votre site. Il doit s’agir de pages avec un fort PageRank et un faible nombre de liens sortants. Il faut se méfier des liens JavaScript ou Flash qui sont mal pris en compte par les moteurs de recherche. Il est important de nouer de vrais partenariats pour augmenter son indice de popularité et non des offres d’augmentations qui ne sont pas très fiables.

Pour ce qui est des liens sortants, il y a quatre règles primordiales :

- Il faut proposer le moins possible de liens sortants aux moteurs de recherche depuis une page populaire.

- Il est important que les liens sortants traitent du même domaine que votre site.

- Il faut travailler les textes de vos liens sortants.

- Les liens les plus importants sont ceux dans la partie éditoriale de votre site. Soignez les le plus possible.

Il semble aussi important de faire un point sur le TrustRank, ce paramètre utilisé aujourd’hui par les moteurs de recherche permettant à ceux-ci de ne plus se baser uniquement sur les facteurs vus précédemment mais aussi sur le contenu du site, les avis des utilisateurs, les sites de confiance auxquels le site est rattaché. Il va prendre énormément de facteurs en compte (le nombre de clics sur le site par utilisateur, la taille du site, le trafic, la taille des articles, l’orthographe, les boutons j'aime,...).

2.2 Les différents services de Google

Il semble important de faire un point sur les différents services Google. Bien qu'ilsne soient pas forcément destinés à référencer votre site, ils peuvent permettre un meilleur référencement. En effet votre site pourra alors apparaître à plusieurs endroits. Par exemple lors d'une recherche d'adresse avec Google Map ou sur une recherche d'image par Google Image. Voici comment ces services influent sur le référencement :

Google Map : il suffit de s'inscrire sur Google Adresse et cela permet d'être référencé sur Google Map. Cela permet d'obtenir le premier résultat lors d'une recherche de lieu. Il ne s'agit pas d'un outil de référencement en soit mais il peut permettre une meilleure visibilité de votre entreprise sur la toile, puisque Google essaie au maximum d’ajouter une case Google Map dans ses résultats de recherche dès que c’est possible.

Si votre site contient des images il est important de les faire référencer par Google Image. Le robot référençant les images n'est pas le même et il se base sur les critères suivant afin de référencer vos images :

- La balise alt de votre image se doit de contenir une description détaillée de votre image. Il est important que cette balise contienne des mots clés. Cela permet au robot d'associer votre photo à votre description.

- La balise title de votre photo est aussi importante et doit contenir une description.

- Il faut absolument nommer vos images. Un nom sans aucun sens ne sera pas bien référencé par Google.

- Les images que vous mettez sur votre site doivent avoir un lien avec le texte autour de celles-ci.

De la même manière, entretenir une chaine Youtube (plate-forme vidéo de Google) avec des vidéos dont le titre est optimisé (comme pour votre site) et des liens pointant vers votre site est extrêmement intéressant pour apparaître dans certains résultats sur Google. Il est également important pour les vidéos d’insister sur les dix premières secondes de la vidéos (qualité optimale = envie de continuer) et faire en sorte que l’image de présentation de la vidéo (qui apparaîtra lors du partage de celle-ci et avant son lancement) donne envie de la regarder.

Google Analytics est un autre outil Google. Cet outil permet d'analyser les différentes statistiques de votre site internet. Grâce à cet outil vous pouvez donc maximiser votre référencement en vous focalisant sur les points vous attribuant le plus de trafic. Cela permet entre autre de dépenser votre argent plus efficacement pour votre référencement. Voici les différents points que Google Analytics peut vous permettre d'améliorer :

- L'optimisation de vos mots clés (Adwords). Grâce à Google Analytics vous pouvez identifier les mots clés vous rapportant le plus de visiteurs et même éliminer ceux vous en faisant perdre. Si vous acheter des mots clés vous pouvez donc acheter uniquement les mots clés les plus importants. Cette astuce peut vous faire économiser beaucoup d'argent et vous permet d'axer votre recherche de mots clés en utilisant les différentes informations fournies par Analytics. Cela vous permet donc de valoriser les mots clés qui vous sont profitables en éliminant les mots clés « stériles » (non-efficaces).

- Grâce au ciblage géographique de Google Analytics vous pouvez voir d'où provient la majorité des utilisateurs de votre site. Grâce à Adword vous pouvez ainsi cibler géographiquement vos campagnes. Cela permet aussi de cibler un sous-groupe d'utilisateurs d'une certaine région.

- Pour un site d'e-commerce Google Analytics permet de faire le lien entre les mots clés (Adwords) et les produits que vous vendez. Il vous permet également de comparer le trafic qui vous rapporte de l'argent des autres.

Google AdWords vous permet d'acheter des mots clés sur Google afin d'être référencé. Il peut s'agir là d'un bon complément à un référencement naturel.

2.3 Google Panda

Google s'est beaucoup fait critiquer sur la qualité de ses résultats. Qualité qui avait encore diminué fin 2010. Google était en train de préparer un nouvel algorithme afin de pallier au manque de qualité de ses résultats. En février 2011 sort Google Panda, un nouvel algorithme spécialement conçu pour cibler les fermes de contenu, les scrappers (copieurs de contenu) et des sites intermédiaires entre Google et les internautes. Depuis la sortie de Panda un peu plus d'un an s'est écoulé et il est temps de faire un point sur les changements qu'a apporté cet algorithme.

2.3.1 Historique des mises à jour de Panda

Depuis qu'il a sorti son algorithme Google a très souvent mis à jour Panda. Voici les mises à jour ayant le plus influencé les résultats de Google :

- Panda 1.0 : 24/02/2011. Panda est introduit aux Etats-Unis uniquement. Il ne concerne que les requêtes en anglais. De nombreux site ont chuté après cette mise en place. Les cibles de Google furent les principales concernées, mais il y a eu de nombreuses critiques dû aux dommages collatéraux de Panda. Des sites ayant un contenu de qualité ont dû subir de violentes chutes à cause de l'algorithme.

- Panda 2.0 : le 11 avril 2011, Google étend Panda au reste du monde. Les requêtes en anglais restent les seuls concernées. Même si la mise à jour 2.0 était pour étendre l'algorithme il y a eu de nombreuses modifications. Plusieurs analyses démontrent qu'il s'agit d'une version Panda 2. Dorénavant il est possible de bloquer certains sites lors de mêmes recherches fréquentes. Cela permet aux internautes de personnaliser leur résultat Google. Mais ces informations concernant les sites bloqués sont récupérées dans l'algorithme de Panda. Si un site est bloqué par un trop grand nombre de personnes il y a de fortes probabilités pour que son classement chute.

- De la version 2.1 à 2.3 il n'y a pas d'évolutions majeures et seules les requêtes en anglais sont concernées.

- La version 2.4 le 28/09/2011 étend Panda à toutes les langues sauf trois Asiatiques. Panda arrive donc en France.

- Jusqu’à la version 3.5 il n'y a pas de modifications majeures de l'algorithme. Une modification mineure se fait par la version 3.1, sinon uniquement les données sont mises à jour cela ne concerne qu'une infime partie des requêtes.

- La version 3.5 du 19/04/2012. Cette mise à jour est sortie quelques jours avant le Black Hat SEO Google Update, qui avait pour vocation à bannir certaines utilisations Black Hat (qui ne respectent pas les normes Google). Il s'est avéré que cette mise à jour fut en réalité un algorithme contre le référencement black hat et qu'elle fut en partie un update AntiSpam. Après cette mise à jour de nombreux sites ont perdu leur classement dans les résultats Google. Voici les types de sites qui ont perdu depuis la mise à jour 3.5 :

- Les sites qui publient des données agrégées issues de bases de données. Par exemple des sites qui donnent des statistiques sur chaque nom de domaine de la planète.

- Les portails de presse et les agrégateurs d'actualité. Soit les sites permettant de réunir des informations sur l'actualité. Ces sites sont ciblés une fois de plus par Google qui les avait déjà ciblés avec Panda.

- Les sites basés énormément sur des modèles de pages (templates)

- Les digg-like. Similaire à digg.com qui pourrait bien être lui aussi touché. Soit un site réunissant des topiques qui ont été énormément abordés sur Facebook et Twitter.

- Un nouveau filtre antispam est également sorti le 26/04/2012, appelé Penguin. Cet algorithme est en fait une extension de Panda ciblant particulièrement le référencement blackhat. La cible prioritaire de Penguin est le netlinking. Ce qui avait été mentionné par Matt Cutts comme étant de la sur-optimisation concernait en fait le webspam. L'impact de cet algorithme serait de 3% à 5% des requêtes.

2.3.2 Comprendre Google Panda et s'adapter

Dans cette partie nous allons résumer les différents critères pris en compte par Panda et donc les éléments à éviter afin de ne pas subir de chute à cause de cet algorithme. Nous évoquerons aussi la méthode à adopter afin d'être bien référencé par Panda.

- Les critères sanctionnés par Panda :

- Faible quantité de contenu original

- Faibles nombre de backlinks, ou backlinks de mauvaise qualité

- Faible durée de visite

- Fort pourcentage de pages en duplicate content (pages similaires sur un site)

- Fort taux de rebond

- Forte proportion de publicités

- Rédaction qui ne semble pas naturelle

- La stratégie à adopter sur ses liens :

- Eviter d'avoir le même texte de lien

- Eviter les services de spinning d'article pour obtenir des liens

- Faire attention aux sites de publication d'articles il est important de viser la qualité

- Eviter les liens non pertinents dans les articles invités

- Les backlinks n'étant pas condamnés par Panda :

- Linkbaiting (liens cherchant à attirer l'attention de l'internaute, car il va lui fournir des informations supplémentaires par rapport à la page qu'il est en train de consulter)

- Annuaires de qualité pertinents

- Sponsoring d'œuvres de charité

- Concours

- Conférences

- Création d'outils de contenu de référence

- Recherches de liens par contact email

- La méthode à adopter pour apprivoiser Panda :

- Tout d'abord il vous faut identifier les pages de votre site qui sont encore bien référencées et celle qui ont chuté. Une fois cela fait, il faut les comparer afin de comprendre ce qui change entre ces pages et donc la cause de la chute. Il faut donc soit supprimer les pages mal référencées si cela est possible et sinon suivre le même type de référencement adopté sur les pages référencées correctement.

- Privilégier la qualité sur la quantité.

- Ne pas dupliquer le contenu. Les copier/coller d'articles existants sera souvent perçu par Google Panda comme un contenu de faible qualité.

- Limiter la publicité. Panda estime qu'une surabondance de publicité est nuisible au contenu et est assimilé à du spam.

- Eviter les liens douteux. Jusqu'à maintenant il était conseillé de mettre un maximum de liens sur son site afin de se promouvoir. Aujourd'hui Panda ne prendra en compte que les liens de qualité en rapport avec votre site. Les liens jugés douteux par Panda pénaliseront votre site plus qu’autre chose.

- Promouvoir les contenus de réseaux sociaux, un article de votre site faisant le buzz sur les réseaux sociaux améliorera de façon significative votre classement.

- Le temps de chargement est un élément essentiel pour Panda, ainsi si votre site rame il sera sanctionné très rapidement par l'algorithme de Google.

- Enfin il est important de surveiller son taux de rebond. Le taux de rebond est le pourcentage d'internautes qui sont entrés sur une page Web et qui ont quitté le site juste après. Il n'ont vu qu'une seule page. Un taux de rebond élevé peut refléter l'insatisfaction de vos visiteurs. Ce taux est consultable grâce à Google Analytics et il est important de le garder au minimum.

2.3.3 Conclusion sur Google Panda

Avant Panda la quantité était à privilégier, lorsqu'un site avait suffisamment de notoriété chaque page ajoutée à ce site pouvait maintenir sa notoriété quel que soit le contenu de la nouvelle page. C’est afin d'améliorer la qualité des sites proposés en première position par Google qu’a été mis en place ce nouvel algorithme.

Globalement Panda a largement modifié les critères de référencement Google. Cet Algorithme a donc largement favorisé certains sites par rapport à d'autres. Les sites de grandes marques ont largement profité de cet algorithme alors que les gros sites sans marques avec énormément de contenus trop variés ont été sévèrement touchés. Les petits sites ont quant à eux été relativement épargnés.

Les sites principalement touchés par Panda ont été les fermes de contenus, les petits sites e-commerce avec beaucoup de pages produit de faible contenu, les sites immenses en nombre de pages, sans marque et sans stratégie marketing.

Grâce à Panda,Youtube a particulièrement amélioré son classement, les grands sites média, les grands sites marchands ainsi que les petits sites de niche ayant profité de l'effondrement des fermes de contenus sont les grands gagnants de ce nouveau référencement Google.

3. Référencement et réseaux sociaux

3.1 Introduction

3.1.1 Qu'est ce qu'un réseau social ?

Les réseaux sociaux existaient bien avant Internet : ils ne sont en effet rien d'autre qu'un groupe de personnes ou d'organisations reliées entre elles par les échanges sociaux qu'elles entretiennent. Aujourd'hui, l’avènement d’Internet a démultiplié ces réseaux et interactions et les a dotés d'une toute nouvelle puissance.

Avec des taux de connexion qui ne cessent de grimper, une créativité débridée, une population de jeunes qui sont de plus en plus tôt en contact avec ces nouvelles technologies et qui arrivent sur le réseau chaque année, des technologies collaboratives qui se banalisent et un désir certain d'investir le champs du relationnel, Internet met en place de nouveaux réseaux sociaux plus larges, plus vastes, plus ludiques mais aussi moins facilement identifiables que ceux auxquels la génération précédente était habituée.

En France, les plus connus des réseaux sociaux se nomment Facebook, Twitter, Skyblog, MySpace ou encore LinkedIn. Chaque réseau comporte ses propres spécificités : réseaux professionnels ou amicaux, centrés sur la musique ou à destination des plus jeunes, etc. Similaires dans leurs principes avec toutefois des différences de style ou d’approche, les sites communautaires proposent aussi la mise en relation d'internautes autour d'intérêts communs. C'est le cas de sites comme Dailymotion ou Youtube, qui ne sont pas à proprement parler des réseaux sociaux mais participent de cette mouvance, car ils perdraient une part de leur intérêt sans la communauté qui les anime.

Véritable phénomène de société chez les jeunes, avec des taux de progression et de pénétration impressionnants, les réseaux sociaux représentent de nouveaux modes de socialisation extrêmement puissants.

Un réseau social est une application Internet dédiée à la communication avec ses connaissances, à la rencontre de nouvelles personnes ou à la construction de son réseau professionnel.

Le principe de base est le même pour tous les réseaux sociaux : on crée son profil (infos personnelles, photo, centres d'intérêt) et l'on invite ses «amis» à nous rejoindre. Chaque contact qui accepte l'invitation accroît le réseau de nouveaux contacts. Les arrivants inscrivent à leur tour leurs contacts et ainsi de suite...

3.1.2 Présentation des principaux réseaux intéressants

Nous ne décrirons ici en détail que les principaux réseaux intéressants dans notre axe de recherche pour le référencement d’une marque et passerons brièvement sur les autres.

3.1.2.1 FacebookFacebook est un réseau social où chaque utilisateur créée son profil, devient « ami » avec les gens qu’il choisit et peut ensuite communiquer et partager avec eux. Ainsi tout élément qu’il partagera ou message qu’il écrira pourra être vu par ces amis qui pourront s’ils apprécient l’élément le « liker », via un bouton spécial, et à nouveau le partager avec leurs amis.

Facebook est actuellement le premier réseau social au monde, en termes de volume d’utilisateurs comme de données. Populaire depuis 2005, Facebook ne cesse de croître et les entreprises créent maintenant de manière presque systématique une page Facebook, afin de promouvoir leur entreprise ou leur marque.

Sur ce diagramme, on constate bien une croissance constante de la présence de Facebook sur le Web, avec à ce jour près d’un milliard d’utilisateurs inscrits dans le monde, ce qui en fait le plus grand vivier potentiel de visiteurs pour d’autres sites. Il est donc important de retenir Facebook en tant qu’acteur majeur du Web.

3.1.2.2 TwitterTwitter est un réseau social dit de « micro-blogging » dont le principe est de s’exprimer par Tweets, messages de 140 caractères maximum pouvant contenir images ou liens. Chaque utilisateur peut donc bien évidemment rédiger ces courts messages (« twitter ») mais aussi choisir de « suivre » les autres utilisateurs qui lui semblent intéressants et dont il pourra alors voir les tweets défiler au fur et à mesure qu’ils sont émis. Il pourra ensuite prendre les tweets les plus intéressants, les marquer comme intéressants ou les retwitter, permettant ainsi aux gens qui le suivent lui-même de le voir également et de la partager à leur tour.

Avec plus de 500 millions d’utilisateurs qui forment une communauté parmi les plus actives de l’Internet, twitter est un réseau que l’on ne peut plus négliger, d’autant que la circulation des tweets est quasi-instantanée et que twitter est étroitement associé, de par le format des tweets, à un autre secteur en pleine explosion : les Smartphones et l’internet mobile.

3.1.2.3 Google+Google +, qui repose sur le même principe que Facebook, avec un fonctionnement similaire, est, comme son nom l’indique, le réseau social développé par Google. Bien qu’il soit moins fréquenté que les deux précédents (plus de 100 millions d’utilisateurs tout de même), il a implanté des concepts très intéressant au niveau de la diffusion des informations, la personnalisation des URL et la liaison aux sites web externes. De plus, son couplage avec la galaxie Google permet d’optimiser très facilement son positionnement sur le moteur de recherche éponyme car il est extrêmement mis en valeur dans l’algorithme et peut-être mis en parallèle avec d’autres outils Google comme Google Maps ou YouTube.

3.1.2.4 Autres réseauxNous ne nous intéresserons pas pour l’instant aux autres réseaux en détail car soit ils ne rentrent pas dans notre démarche (LinkedIn et Viadeo, très fréquentés, sont des réseaux professionnels axés sur le marché de l’emploi et de la réputation personnelle et non des marques par exemple) soit ils sont encore trop peu développés pour qu’une présence y soit significative pour une marque, à part dans des domaines vraiment spécifiques.

Il est cependant très important de surveiller ce domaine qui est en ébullition constante, la réussite de Facebook et Twitter attirant les imitateurs désireux de percer. Par exemple, il peut être intéressant de surveiller de nouveaux réseaux qui commencent à émerger et se faire une réputation, comme Tumblr ou Pinterest qui sont respectivement le moteur de blog le plus couru au monde et le dernier concept en date pour le partage de contenu simplifié.

3.1.3 Pourquoi s'y intéresserPour une partie importante des internautes, les réseaux sociaux permettent avant tout de mettre en avant leur réputation virtuelle. Cependant selon une enquête menée par Acxiom en 2010, 42% des gens utilisent les réseaux sociaux pour partager des photos, des vidéos et des liens et 32% des gens utilisent les réseaux sociaux pour échanger des informations. Ces chiffres nous montrent l’importance des réseaux sociaux dans l’utilisation du web qui est faite par les internautes en ce qui concerne l’échange et la transmission de l’information.

Pour un annonceur, il peut être très intéressant d'intégrer un réseau social afin de communiquer directement auprès de publics ciblés. En effet, il existe plusieurs catégories de réseaux sociaux dont les membres sont différents : réseaux sociaux professionnels, pour les jeunes, réseaux spécialisés (dans les vidéos, les images ...), communautaires et thématiques, etc.

Ainsi Facebookest le réseau social qui permet d’échanger le mieux au niveau personnel. Il permet de partager des articles de blogs, des photos, des vidéos, des sondages et des liens dans un même espace. Twitter est idéal pour partager des informations courtes (140 caractères max), surveiller les impressions des clients et en trouver de nouveaux. LinkedIn est une plateforme qui convient le plus aux professionnels et permet de retrouver d’anciens collègues et parfois de trouver un emploi. Google+ est le must lorsqu’il s’agit de créer des discussions et d’envoyer du contenu à des personnes, en public ou à ses cercles.

Les deux aspects particulièrement intéressants d'un réseau social pour le webmarketing sont le dynamisme des membres et le niveau de confiance qu'ils portent les uns envers les autres. Grâce à cela une information jugée intéressante par un internaute pourra très rapidement être diffusée à d'autres et bientôt propagée à l'ensemble du réseau.

De plus, les moteurs de recherche sont sensibles aux différentes spécificités des réseaux sociaux (« J’aime » [Facebook], « ReTweet » [Twitter], etc.). Par exemple, Google indexe les pages ayant le plus de ReTweets et non celles ayant le plus de backlinks. Cette indexation semble logique étant donné que la popularité d’une page n’est plus exclusivement déterminée par son nombre de backlinks mais aussi par l’appréciation des internautes (représentée par les ReTweets).

L’utilisation des réseaux sociaux comme outil de référencement peut paraître assez opaque au début, mais une fois habitué au système, celui-ci devient très accessible et redoutable.

3.2 Importance des réseaux sociaux

3.2.1 Approche

On peut donc faire connaître sa marque en lui offrant un espace sur les principaux réseaux sociaux (page fan de Facebook, flux Twitter, page pro Google+,…) et essayer de faire le « buzz » pour se rendre visible. Ce moyen de se faire connaître a de plus un autre grand avantage : il est pris en compte dans le référencement de votre site web.

Le « buzz », issu du terme anglais signifiant « bourdonnement », consiste à faire du bruit autour d'un évènement, d'un produit ou d'une offre. C’est une technique de marketing permettant de promouvoir très rapidement un produit.

Concernant l'aspect référencement, le buzz permet d'avoir énormément de liens pointant sur la page de votre site, attirant ainsi un maximum de visiteurs, ceux-ci en parlant activement autour d'eux, faisant augmenter les liens externes vers le site (backlinks) de manière exponentielle. Ceci fait augmenter la notoriété du site Internet (appelé aussi autorité) auprès des moteurs de recherche. Ainsi les algorithmes de positionnement des moteurs de recherche considèreront le site pertinent et le positionneront avant les autres dans la liste de résultats de recherche. Ce phénomène est apparu avec le développement des réseaux sociaux, qui permettent le partage de liens à très grande échelle, et en très peu de temps.

Ainsi une page Facebook ou un compte Twitter publiant des liens vers une page précise (un produit précis) sur le site sera mis en valeur dans les résultats des moteurs de recherche non seulement pour cette page mais pour le site lui-même. De plus, l’effet est cumulé : plus les gens « partageront », votre contenu, c’est-à-dire reprendront votre lien pour le diffuser, plus l’influence sur les résultats des moteurs sera grande.

Ainsi, tout en vous faisant connaître via ces plateformes sociales par le partage des informations que vous diffusez, cette diffusion permettra de mettre en valeur votre site web dans les résultats des moteurs de recherche. C’est cette fois-ci un triple avantage car les personnes qui viendront vers votre site en passant par les réseaux sociaux vont également générer du trafic sur vos pages et ainsi les faire remonter dans les résultats donnés par Google et Bing et, si ce qu’ils trouvent leur plaît, ils vont en plus relayer l’information sur les réseaux sociaux, créant ainsi une spirale vertueuse amenant de plus en plus de visiteurs sur votre site et tirant celui-ci vers le haut du classement.

3.2.2 Quel rôle dans le référencement

L’arrivée récentedu nouvel algorithme Google a déjà commencé à changer le fonctionnement du référencement naturel des sites web. Google Panda est en effet beaucoup plus orienté vers les réseaux sociaux, car il prend en compte les pages qui circulent sur ces réseaux pour prendre en compte les sites dont le contenu est de bonne qualité. La transition et la prise en compte, quoique moins importantes, avaient déjà été effectuées par Bing auparavant.

Il y a plusieurs moyens simples pour les moteurs de savoir si le contenu d'une page a intéressé des internautes en passant par les réseaux sociaux :

- Le bouton +1 de Google +