Veille technologique Simulation numérique

Travail effectué par les étudiants de l'EPU Lyon 1 dans le cadre du module Veille technologique, disponible librement sous la forme d'un livre blanc.

![]() Nous contacter

Nous contacter

Introduction

Dans le cadre du cursus au sein de l'école ISTIL EPU Lyon1 un travail de veille technologique a été réalisé pour l'UE Veille technologique.

L'entreprise partenaire SOLYSTIC :

Société Anonyme Simplifiée au capital de 26 101 980 €, enregistrée au Registre du Commerce et des Sociétés de Créteil sous le numéro 393 502 463, dont le siège social est situé 14, avenue Raspail – 94250 Gentilly

est l'entreprise porteuse du projet de veille réalisé cette année scolaire 2009-2010.

Pour des raisons de confidentialités vis à vis de SOLYSTIC, seules les technologies non relatives à SOLYSTIC seront présentes dans ce livre blanc.

Serious Game

1.1. Introduction sur les Serious Game

L’industrie vidéo-ludique a réellement pris son envol au début des années 80 avec, par exemple, la popularisation du célèbre jeu Pong. Bien qu’encore fébrile aux Etats-Unis, le jeu vidéo migre au Japon. On voit alors apparaitre quelques éditeurs sur le marché dont Nintendo. D’année en année, les jeux vidéo deviennent de plus en plus accessibles au grand public et s’encrent donc de plus en plus dans notre société.

Les « jeux sérieux », ou « Serious Game », s’inscrivent dans cette lignée. Ils s’appuient sur les progrès des jeux vidéo mais tentent d’offrir, en plus de l’expérience ludique, un message. En général, le budget alloué à ces Serious Game est peu élevé par rapport aux jeux vidéo standards, ce qui explique le rendu graphique de ceux-ci.

Le Serious Game le plus connu à l’heure actuelle est America’s Army, jeu développé pour le secteur de la défense aux Etats-Unis. Celui-ci a pour vocation de redorer le blason de l’armée américaine et ainsi attirer le jeune public.

1.2. Définition

« La vocation d'un Serious Game est d'inviter l'utilisateur à interagir avec une application informatique dont l'intention est de combiner à la fois des aspects d'enseignement, d'apprentissage, d'entraînement, de communication ou d'information, avec des ressorts ludiques issus du jeu vidéo. […] Pour opérer cette mise en relation entre l'aspect utilitaire et le jeu vidéo, le concepteur va mettre en relation deux types de scénarii : le premier sera d'ordre utilitaire, le second sera d'ordre purement ludique » (définition de Laurent MICHAUD – Document IDATE).

Scénario utilitaire + scénario vidéo-ludique = serious game

1.3. Type de Serious Game

On distingue trois grands types de Serious Game :

- les Serious Game à message : rôle de diffuseur d’information, le message peut être éducatif, informatif ou persuasif

- les Serious Game d’entrainement : leur rôle est d’améliorer les performances cognitives ou motrices des utilisateurs

- les Serious Game de simulation

1.3.1. Les Serious Game à message

Ceux-ci peuvent être classés en plusieurs sous-catégories :

- Les edugames : l'ambition d'une application ludo-éducative est de transmettre un enseignement en mobilisant des ressorts ludiques.

- Les advertgames : l'approche d'un advergame consiste souvent à se baser sur le gameplay de jeux vidéo connus pour en faire un outil de communication. L'idée est de libérer le joueur de l'apprentissage du gameplay pour lui permettre de se focaliser sur les habillages graphiques ou sonores de l'application qui véhiculent les marques ou les produits mis en valeur.

- Les jeux vidéo informatifs : désignent les Serious Games dont l'intention est d'informer ou de sensibiliser les utilisateurs à un message, souvent lié à un enjeu social.

1.3.2. Les Serious Game d’entrainement

Cette catégorie regroupe les serious game simulant un système avec lequel les utilisateurs sont invités à atteindre un objectif précis pour être évalués. L'idée ést de conduire les utilisateurs à affiner leur savoir-faire sur un plan psychomoteur ou purement cognitif.

Ces Serious Game sont souvent présents dans le secteur de l’éducation et de la santé. On peut citer dans le domaine de la santé le Serious Game Pulse qui propose de diagnostiquer des patients et de leur administrer les soins les plus adaptés.

1.3.3. Les Serious Game de simulation

Cette dernière catégorie recense les serious game dont la base vidéo-ludique est dénuée d'objectif final visant à évaluer les utilisateurs. Seul l'univers proposé ou le système simulé par l'application et la manière d'y interagir fixent un cadre.

On peut citer September the 12th qui met en scène une ville du Moyen-Orient infestée de terroristes. L’utilisateur a le choix entre lancer des missiles ou ne rien faire. Sachant que lorsqu’un utilisateur lance un missile, celui-ci ne détruit pas entièrement sa cible et cause la mort de certains civiles qui, rongés par la haine, deviendront eux aussi des terroristes. Le message que veut faire passer ce jeu est que la violence engendre la violence.

1.4. Secteurs d’application

Nous avons déjà commencé à introduire quelques domaines d’applications dans les paragraphes précédents. Nous en avons recensé six :

Secteur de la Défense

Sans équivoque possible, c’est le secteur le plus développé et plus particulièrement aux Etats-Unis où l'on observe une forte corrélation entre l’armée et les Serious Game. Comme dit précédemment, on peut citer America’s Army mais aussi des jeux plus connus tel que Flight Simulator.

Secteur de la formation et de l’enseignement

Ce secteur est en pleine expansion depuis quelques années. Les Serious se présentent clairement comme l’évolution des solutions E-Learning d’aujourd’hui, d’ailleurs une étude faite par l’IDC : « En 2008, le serious game était d’ailleurs utilisé dans 40% du marché du e-learning. » (http://www.seriousgaming.fr/definition-serious-game/)

Secteur de la publicité

Les serious games dédiés à la publicité offrent la particularité d'exposer sur toute la durée d'une partie vidéo-ludique l'utilisateur à une marque ou un produit.

Secteur de l’information et de la communication

Dans ce cadre, les Serious Games véhiculent des messages dans divers domaines. On peut citer Interactive Night Out (http://willinteractive.com/products/interactive-nights-out-1) qui traite le problème des MST (domaine de la santé). Ce secteur est souvent couplé à celui de la publicité. Les Serious Game dans ce secteur sont largement minoritaires par rapport à ceux de la défense et de l’éducation.

Secteur de la santé

Les serious games dédiés au secteur de la santé ont pour vocation d'améliorer les capacités mentales et physiques des utilisateurs.

Dans ce secteur, on retrouve tous les programmes d’entrainement conçus sur la console Wii et Ds de Nintendo. Ce marché prend de l’ampleur : en 2007, ce marché représentait 225 millions de dollars seulement sur le sol américain.

Il apparait que ce secteur a un grand potentiel. De nombreux acteurs tels que Ben Sawyer disent que ce secteur pourrait bien avoir une forte croissance.

Secteur de la culture

Ce secteur est très minoritaire. Il est souvent question de tourisme : capter plus de public dans les musées, visites de lieux touristiques en 3D, etc.

Ces Serious Game peuvent permettre, par exemple, de visiter des lieux hostiles (nucléaires,…) ou fragiles (écosystème, monuments anciens,…) dont l’accès serait normalement très restreint.

1.5. Cibles visées par le serious game

Dans cette partie, il est question de savoir a qui est adressé un Serious Game. Les cibles peuvent être de deux sortes : les utilisateurs et les commanditaires.

1.5.1. Les utilisateurs potentiels

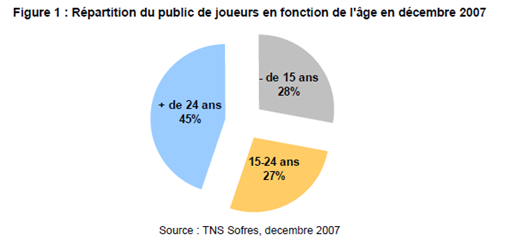

Les Serious Game étant une sorte de jeux vidéo, une première estimation des utilisateurs potentiels serait de découper la population adonnée aux jeux vidéo par tranche d’âge, comme le montre la figure ci-dessous. La moyenne d’âge est de 25 ans.

Moins de 15 ans

« Dès 4 à 5 ans, les enfants sont capables d'identifier si les applications offrent un véritable gameplay ou simplement un habillage ludique de façade. Dès 5 à 6 ans, certains enfants sont à même de recopier dans un navigateur Internet des URL de sites de jeux vus dans des émissions télévisées ou sur support papier. Dès 6 à 7 ans, des enfants se déplacent finement dans des environnements en 3D temps réel. […] En dessous de 9-10 ans, cependant, les enfants ont bien souvent besoin de la présence d'une personne plus âgée pour assurer la maintenance technique le cas échéant. »

Pour les Serious Game, un enfant de cet âge se délaissera assez rapidement du contenu si celui-ci n’est pas encadré ou que le contenu n’est pas assez attractif. La présence d’un adulte est donc requise.

De 15 à 24 ans

Le public de cette tranche d’âge est plus exigent sur la qualité du graphique et du gameplay. Or les budgets alloués aux Serious Game sont généralement nettement inférieurs aux jeux vidéo de renom. Le contenu utilitaire d’un Serious Game peut aussi être un frein car il y a des chances pour que celui-ci rime avec effort. Pour passer outre cette barrière, il faut que le Serious Game soit utilisé dans un contexte approprié. Par exemple, dans une école pour une formation, l’aspect nouveau et dynamique par rapport à des cours normaux rendront son emploi beaucoup plus attractif. Pour palier le problème de budget, il peut être intéressant de faire des Serious Game à l’image des casual games car ceux-ci touchent et ont un grand succès auprès de gens de tout âges. De plus, leur conception ne demande pas un grand budget.

Plus de 24 ans

Pour les plus de 24 ans et jusqu’à 55 ans environ, le temps consacré à la pratique du jeu vidéo diminue en fonction de l’âge. Cette diminution peut s’expliquer par des obligations professionnelles et familiales qui n’existent pas chez les moins de 24 ans. De plus la génération des au-delà de 35 ans n’ont pas connus l’effervescence des jeux vidéos dans leurs enfances, ils ne retrouvent donc pas le même intérêt. En revanche, on observe que les personnes de plus de 55 ans se familiarisent de plus en plus avec la technologie, dû à leur nouveau temps libre (retraite…). On retrouve donc de plus en plus de senior à jouer à des jeux de type casual game.

Des sociétés telles que Némopolis ont déjà pris en compte de tels paramètres et vendent des edugames historiques avec un livre associé pour que des liens intergénérationnels puissent s'établir : les grands-parents lisent le livre, les enfants utilisent le cédérom.

Nintendo, quant à eux, grâce à la Wii ou encore grâce à la DS, propose de plus en plus de titre accessible tout public sur les thèmes de la santé et du bien être (Entrainement cérébral Dr. Kawashima, Wii Fit, etc.)

A noter que le concours Lépine 2008 a récompensé un ordinateur possédant une interface simplifiée et étudiée pour les personnes âgées (http://www.zdnet.fr/actualites/informatique/0,39040745,39380956,00.htm)

1.5.2. Les commanditaires

La défense

C’est le plus gros commanditaire actuel (en particulier aux Etats-Unis). C'est le pionnier du domaine, celui qui finance les plus importantes productions à l'instar d'America's Army. De plus, elle ne soutient pas que les Serious Game à vocation militaire, on peut par exemple citer Pulse!. La défense étatsunienne finance aussi certains serious game d'entraînement médical sous forme de bourse fédérale à hauteur de 7 millions d’euros. A noter aussi que la NSA a également commandité son propre Serious Game, Ground Truth, dont l’objectif est d'informer le public sur la manière de réagir face à des catastrophes naturelles ou des attaques terroristes.

En France, l’acteur majoritaire est aussi la Défense, mais dans des proportions plus réduites. Par exemple, elle a fait appel à la société Paraschool (groupe Editis) pour réaliser son propre Serious Game, Mission Défense. L’objectif de celui-ci est de sensibiliser les collégiens aux différents types de missions qu’effectue l’armée française.

Les entreprises et autres institutions privées

Pour les entreprises et institutions privées, on peut séparer les Serious Game en deux registres : la communication et la formation professionnelle. Pour la communication, comme nous l’avons dit précédemment, cela passe par la commande de Serious Game de type advertgame. Pour les Serious Game de formation professionnelle (domaine spécialisé), les entreprises font en général appel à des sociétés ou éditeurs spécialisés.

Les institutions publiques

Celles-ci commandent essentiellement des Serious Game à message ou d’entrainement. Des études sont actuellement en cours sur les bienfaits des Serious Game dans les cursus scolaires.

Les éditeurs

Les éditeurs font aussi partis des commanditaires, qu’ils fassent parti du monde du jeu vidéo, du ludo-éducatif ou autres. Tout comme beaucoup de métiers, il est parfois préférable de sous-traiter une partie où l’éditeur n’est pas expert.

1.6. Modèle économique

Il existe trois types de segments dans l’industrie du Serious Game :

1.6.1. Le segment B2B

Dans ce segment, trois modèles en découlent :

Modèle par commande

Il repose sur une demande formulée moyennant finance par un commanditaire auprès d’un prestataire représenté par toute entité, à l’exception d’un particulier, qui soit à même de concevoir et de développer un Serious Game. Ce dernier se destine à l’usage du seul commanditaire.

Modèle par vente de License

Il repose sur la mise à disposition moyennant finance d’une application produite par un éditeur, une société, un indépendant, une association ou une institution publique ou privée auprès de toute entité, à l’exception d’un particulier. L’application est ici, soit un Serious Game prêt à l’emploi – personnalisable ou non –, soit un logiciel de création permettant de générer un Serious Game, soit encore un Serious Game intégré au sein d’une application ou un produit tiers.

Modèle formation / consulting

Il se base sur le service qui consiste à former les concepteurs et les développeurs d’une institution publique ou privée aux approches du Serious gaming, in situ, durant les différentes phases de production de l’application.

1.6.2. Le segment B2C

Le modèle éditeur/ développeur repose sur l’initiative d’un éditeur, d’une société, d’un indépendant, d’une association ou d’une institution publique ou privée, qui va concevoir, développer et proposer directement à la vente, sans demande ou commande préalable, un Serious Game prêt à l’emploi – personnalisable ou non – auprès de tous types de consommateurs.

1.6.3. Le segment B2B2C

On retrouve ici les trois modèles économiques du B2B. La différence étant que le commanditaire joue ici le rôle d’un intermédiaire entre le développeur et le consommateur du Serious Game.

1.7. Les serious Game : technologies clés des prochaines années

Un rapport du ministère de l’industrie classe les serious game comme une technologie qui va évoluer dans les prochaines années.

La réalité augmentée est un cas particulier de réalité virtuelle consistant à superposer un « monde virtuel » au monde réel, généralement pour servir un objectif particulier tel que la visualisation d'informations.

Ces trois domaines exploitent les technologies informatiques et les interfaces matérielles, en particulier :

- les moyens informatiques, matériels et logiciels permettent de réaliser techniquement un environnement virtuel interactif qui puisse être interfacé avec l'utilisateur ;

- les technologies permettant la simulation en temps réel d'entités (objets, personnages virtuels, etc.) selon des lois physiques (mécaniques, optiques, acoustiques, etc.) et des lois comportementales (psychologiques, sociales, affectives, etc.) ;

- les moyens matériels permettant la communication entre l'utilisateur et le monde virtuel. On distingue deux types d'interfaces, les interfaces sensorielles qui permettent d'informer l'utilisateur par ses sens de l'évolution du monde virtuel et les interfaces motrices qui informent l'ordinateur des actions de l'utilisateur sur le monde virtuel.

Les deux problèmes majeurs de la réalité virtuelle sont la création du monde virtuel et l'interfaçage entre le sujet et le monde virtuel. Les difficultés rencontrées sont de trois ordres :

- il faut modéliser et traiter informatiquement un monde virtuel évoluant en temps réel : les modèles peuvent être simplement descriptifs, au comportement déterministe, ou autonomes et requièrent des temps de calcul généralement très importants ;

- l'interaction en temps réel est obtenue si l'utilisateur ne perçoit pas le décalage temporel entre son action sur l'environnement virtuel et la réponse sensorielle. Cette contrainte étant difficile à satisfaire, on cherchera à minimiser les perturbations induites par ce décalage au niveau de la perception de l'utilisateur ;

- l'immersion de l'utilisateur ne peut pas être naturelle dans la mesure où nous sommes conditionnés à agir naturellement avec un environnement répondant à des lois naturelles. La réalité virtuelle cherche à créer un environnement le plus naturel possible, on parle alors d'immersion pseudo-naturelle. L'efficacité d'une immersion pseudo-naturelle est une notion très subjective qui dépend de l'application et du matériel utilisé.

| Degré de développement : | ||

|---|---|---|

| Emergence | Croissance | Maturité |

Un secteur en croissance qui n’a pas encore atteint sa maturité et qui devrait offrir de nouveaux Marché.

Le marché des Applications de réalité augmenté comme les Serious Game

- visualisation d'informations « tête haute » (dans des situation de conduite routière par exemple) ;

- affichage d'informations contextuelles invisibles à l'oeil nu (chemin à suivre, zones dangereuses ...) ;

- environnements de formation pour l'industrie manufacturière ;

- formation et assistance aux interventions médicales, à partir de données fournies par les scanners modernes dont la résolution approche le millimètre

- prototypage virtuel, maquette numérique ;

- industrie des jeux ;

- TV interactive 3D.

| Degré de diffusion de la technologie : | ||

|---|---|---|

| Naissance | Diffusion | Généralisation |

Compétences technologiques : audiovisuel, télécommunications, informatique, semi-conducteurs, optique.

Pôles de compétitivité : Image, multimédia et vie numérique (Île-de-France), Images et réseaux (Bretagne), Loisirs numériques (Rhône-Alpes), System@tic (Île de France), Elopsys (Limousin, Midi-Pyrénées)

Liens avec (technologies) : processeurs et systèmes ; composants logiciels ; acquisition et traitement de données ; gestion et diffusion des contenus numériques ; modélisation, simulation, calcul ; interfaces humain-machine ; affichage nomade ; capteurs intelligents et traitement du signal, méthodes et outils de conception ; imagerie et instrumentation associées aux sciences du vivant.

Principaux acteurs français

Centres de compétences : Irisa (Rennes), CEA, INT-Artemis (Paris), BRGM, Clarte (Laval)

Industriels : Dassault Systèmes, EDF, PSA, Renault, EADS, Institut Français du Pétrole, CS Communication & Systems, France Télécom, Thales, Sell (Syndicat des editeurs de logiciels de loisirs), Mercury Computer Systems (ex-TGS), RATP, Haption, Simteam

Exemples d'acteurs dans le monde : MIT Medialab (États-Unis), Silicon Graphics (États-Unis), Alias (Canada), Projet IST Olga

2. Émulation et simulation

2.1. Introduction

L'émulation et la simulation ont ceci en commun qu'elles visent toutes deux à virtualiser un système ou un phénomène. Cependant, il s'agit bien de deux concepts différents. En général, l'émulation consiste à imiter le comportement d'une machine grâce à un logiciel, là où la simulation imite un phénomène réel tel qu'un trou noir ou une tornade.

Des débats existent cependant en ce qui concerne la terminologie à utiliser dans certains cas : jusque dans les années 1980 particulièrement, le terme "émulation" faisait référence à l'émulation matérielle, et "simulation" à l'émulation logicielle.

Nous allons donc essayer de définir ce qu'est l'émulation. En effet, il ne faut pas confondre l'émulation et la simulation.

L'émulation consiste à substituer un élément de matériel, comme une machine, par un logiciel.

Il faut voir dans l'émulation une imitation du comportement physique d'un matériel par un logiciel, et ne pas la confondre avec la simulation, laquelle vise à imiter un modèle abstrait. L'émulateur reproduit le comportement d'un modèle dont toutes les variables sont connues, alors que le simulateur tente de reproduire un modèle mais en devant extrapoler une partie des variables qui lui sont inconnues (exemple : la simulation du comportement d'un trou noir). Le recours à un émulateur, selon le contexte, permet de faciliter le développement ou le débogage d'un système ou de remplacer un système obsolète ou inutilisable par un autre. Dans ce cadre, il est possible de faire fonctionner le nouveau système, l'émulateur, de la même manière que le système imité.

La simulation numérique est l'un des outils permettant de simuler des phénomènes réels.

Appelée aussi simulation informatique, elle désigne un procédé selon lequel on exécute un programme informatique sur un ordinateur en vue de simuler par exemple un phénomène physique complexe (ex: chute d'un corps sur un support mou, résistance d'une plateforme pétrolière à la houle, fatigue d'un matériau sous sollicitation vibratoire ...).

Les simulations numériques scientifiques reposent sur la mise en oeuvre de modèles théoriques utilisant souvent la technique dite des éléments finis. Elles sont donc une adaptation aux moyens numériques de la modélisation mathématique, et servent à étudier le fonctionnement et les propriétés d'un système modélisé ainsi qu'à en prédire son évolution. On parle également de calcul numérique.

Les interfaces graphiques permettent la visualisation des résultats des calculs par des images de synthèse.

Source : Wikipedia.

On peut donc voir que l'émulation et la simulation ne sont pas exactement la même chose.

En effet, la simulation consiste à faire un modèle théorique d'une machine ou d'un phénomène physique et de le faire tourner grâce à un programme informatique, pour voir son évolution.

Par contre, l'émulation consiste à mettre en place une imitation d'un comportement physique d'une machine par un logiciel. On sait exactement comment fonctionne la machine, comment elle va réagir et on l'émule pour avoir une réplique logiciel. Les buts de l'émulation sont la réduction des coûts, faciliter le développement d'une application (débogage)...

2.2. Émulation

2.2.1. Différents types d'émulation

On peut trouver différents types d’émulations possibles. En effet, l'émulation s'applique à plusieurs domaines et ne s'utilise donc pas pour le même but.

Émulateur de terminal (lien avec la virtualisation)

L'émulation de terminal s'utilise couramment. Il correspond à la mise en place d'une machine virtuelle qui permet d'émuler un terminal physique. L'émulation est généralement faite dans une fenêtre, ce qui permet d'émuler et utiliser plusieurs terminaux sur un seul moniteur d'ordinateur. On peut donc, par exemple, utiliser des commandes ou des logiciels Windows sur une machine UNIX ou vice-versa.

Une machine virtuelle est un conteneur totalement isolé capable d'exécuter ses propres systèmes d'exploitation et applications, à l'instar d'un ordinateur physique. Une machine virtuelle se comporte exactement comme un ordinateur physique et contient ses propres CPU, mémoire RAM, disque dur et cartes d'interface réseau virtuels (c'est-à-dire basés sur du logiciel).

Un système d'exploitation est incapable de faire la différence entre une machine virtuelle et une machine physique, il en est de même pour les applications ou d'autres ordinateurs attachés à un réseau. Il est important de préciser quand même qu'une machine virtuelle est entièrement composée de logiciels et qu'elle ne contient aucun composant matériel quel qu'il soit. En conséquence, les machines virtuelles offrent des avantages certains par rapport aux matériels physiques :

- Compatibilité : les machines virtuelles sont compatibles avec tous les ordinateurs

- Isolation : les machines sont isolées les unes des autres comme si elles étaient physiquement séparées

- Encapsulation : les machines virtuelles encapsulent un environnement informatique complet

- Indépendance par rapport au matériel : les machines virtuelles s'exécutent indépendamment du matériel sous-jacent (Windows Seven sur un Mac OSX...)

Dans ce domaine, on trouve de nombreuses solutions :

Oracle VM VirtualBox est un logiciel sous licence GNU GPL depuis janvier 2007. Il est développé par SUN Microsystems. Il gère tous les systèmes d'exploitation tels que Windows, Linux ou MacOX.

Oracle VM VirtualBox est un logiciel sous licence GNU GPL depuis janvier 2007. Il est développé par SUN Microsystems. Il gère tous les systèmes d'exploitation tels que Windows, Linux ou MacOX.

VirtualPC est un logiciel propriétaire gratuit d'émulation et de virtualisation. Il permet d'émuler un système d'exploitation sur une architecture matérielle différente de celle à laquelle il était initialement destiné. Il permet également de faire fonctionner en même temps plusieurs systèmes d'exploitation différents sur une même machine physique. C'est la solution de Microsoft pour émuler un terminal.

Workstation permet d'émuler des systèmes d'exploitation complets. Il permet la création d'une ou plusieurs machines virtuelles au sein d'un même système d'exploitation (généralement Windows ou Linux), ceux-ci pouvant être reliés au réseau local avec une adresse IP différente, tout en étant sur la même machine physique. Il est possible de faire fonctionner plusieurs machines virtuelles en même temps, la limite correspondant aux performances de l'ordinateur hôte. C'est l'éditeur VMware qui fabrique cette solution, qui est payante.

Parallels Desktop, de la firme Parallels, est une application de virtualisation fonctionnant sous Mac OS X. Elle permet de faire fonctionner Windows ou tout autre système d'exploitation utilisant un processeur de type x86 sur Mac.

Xen permet d'exécuter plusieurs systèmes d'exploitation (et leurs applications) de manière isolée sur une même machine physique sur tout type de plate-forme. Les systèmes d'exploitation invités partagent ainsi les ressources de la machine hôte. Il s'agit d'un "paravirtualiseur" ou un "hyperviseur" de machines virtuelles. Les systèmes d'exploitation invités ont conscience du Xen sous-jacent, ils ont donc besoin d'être portés (adaptés) pour fonctionner sur Xen.

Xen permet d'exécuter plusieurs systèmes d'exploitation (et leurs applications) de manière isolée sur une même machine physique sur tout type de plate-forme. Les systèmes d'exploitation invités partagent ainsi les ressources de la machine hôte. Il s'agit d'un "paravirtualiseur" ou un "hyperviseur" de machines virtuelles. Les systèmes d'exploitation invités ont conscience du Xen sous-jacent, ils ont donc besoin d'être portés (adaptés) pour fonctionner sur Xen.

Émulateur électronique

Dans le domaine de l'électronique, le terme émulateur représente un dispositif physique (matériel) qui permet de faire du développement et du débogage.

L'émulateur remplace physiquement le microprocesseur à l'aide d'une sonde. L'émulateur remplace ainsi (à l'identique) le microprocesseur d'un point de vue électrique et numérique. La sonde est interfacée avec un ordinateur de développement pour permettre à l'ingénieur de contrôler et d'observer le fonctionnement du microprocesseur émulé (ceci à des fins de test).

On parle d'émulateur temps-réel lorsque celui-ci respecte les contraintes temporelles du microprocesseur comme les cycles d'écriture ou les temps de réponse.

On peut retrouver ici le terme d'émulateur in-circuit (également appelé on-circuit debugger ou background debug module). Il s'agit d'un dispositif matériel qui permet de déboguer le logiciel d'un système embarqué. Un tel dispositif devient de plus en plus important car les systèmes embarqués présentent un certain nombre de lacunes. Ainsi, ils ne comportent ni clavier, ni écran donc aucune interface avec l'utilisateur qui permettrait d'interagir avec le système.

On parle d'émulation in-circuit lorsque l'on branche un émulateur in-circuit sur un système électronique en lieu et place du composant à émuler (souvent un microcontrôleur ou un microprocesseur). Les émulateurs in-circuit permettent alors de faire fonctionner le système tout en permettant de le déboguer.

On peut trouver ici différentes solutions différentes :

dSPACE Simulator est un produit qui permet de mettre en place des tests de logiciel. On peut, par exemple, faire des tests de voitures virtuelles et non pas essai sur route (Audi, Bugatti : tester l'électronique sur une voiture qui va très vite (400 km/h)).

LabView est un produit de la société National Instruments. Elle propose des solutions pour la mise en place de tests.

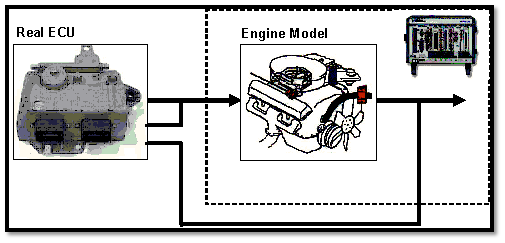

Concept de la notion de Hardware-in-the-loop

On touche ici à la notion de Hardware-in-the-loop (HIL). Cette notion est importante car certains systèmes sont chers et fragiles et donc faire des tests dessus peut être risqué et coûteux.

On effectue une émulation du système à construire pour pouvoir faire des tests "réels" et non pas de la simulation. Si on n'utilise pas le HIL, on peut, par exemple, tester le code d'abord sur un PC de bureau avant d'être porter sur le microcontrôleur final (ou autre). On simule le système embarqué (entrées/sorties) et l'environnement d'exécution avec un code personnalisé sur leur PC.

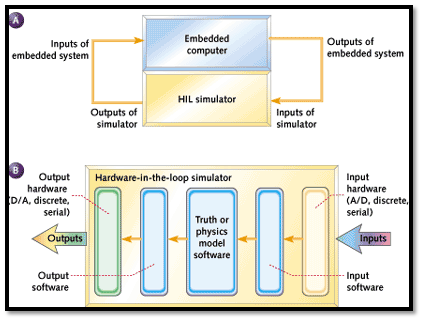

Il existe trois principales différences entre une telle simulation et un HIL.

Tout d'abord, les sorties des simulations ne sont que des lignes ondulées sur un graphique, pas des signaux matériels.

Deuxièmement, la HIL fonctionne en temps réel.

Troisièmement, dans un HIL, le logiciel embarqué s'exécute sur le matériel "réel" que vous finirez par créer dans votre produit, pas un poste de travail.

Schéma explicatif de la notion de Hardware-in-the-loop

On travaille donc avec le même logiciel que l'on va utiliser sur la machine réelle et non pas une adaptation pour tester sur l'ordinateur. Cela permet de ne pas perdre du temps à développer une version pour les tests (qui fonctionne que sur un ordinateur) et une version qui sera embarquée (pour le système à développer).

On a donc des signaux physiques réels en entrée et en sortie et non pas des signaux logiciels.

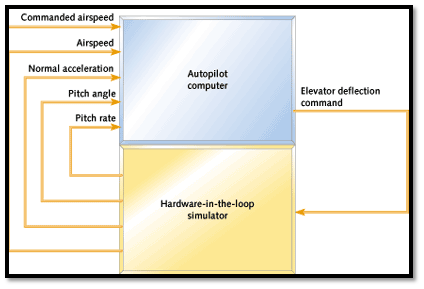

Exemple de Hardware-in-the-loop dans le domaine de l'aviation

Dans cet exemple donné dans le domaine de l'aviation, on peut voir que l'on fonctionne directement avec le système de pilotage automatique. On peut voir que l'on lui donne des données réelles en entrées, il réagit à ces données (on remonte ou on descend en altitude) et le HIL permet de rendre les données relatives aux angles ou à l'accélération (réaction de l'avion au changement d'altitude). On teste donc directement le logiciel de pilotage automatique qui sera implanté dans un avion (stimuli physiques) et non pas une version qui répond à des stimuli simulés.

Le but de la HIL est de tester un système embarqué. La preuve que le système embarqué a passé le test, c'est que ses résultats sont corrects pour les entrées qu'il a été donné. Le HIL doit, par conséquent, fournir des données suivant les paramètres donnés (suivant un calendrier). Un moyen facile de le faire est d'écrire l'état de la simulation dans un fichier.

Le terme "état" désigne toutes les entrées de la simulation, ses sorties, et toutes les valeurs internes qu'elle génère et qui sont utilisées pour calculer les résultats du prochain cycle. À la fin de l'essai, on peut transférer le fichier à un programme comme MATLAB et analyser les résultats.

Cette notion de Hardware-in-the-loop est très présente dans les domaines de l'aviation, de l'automobile, de l'aérospatiale.

Émulateur de jeux

Le dernier type d'émulation concerne les jeux vidéo. On fait une émulation des consoles de jeux que l'on alimente par des ROM. L'extension des fichiers ainsi que les renseignements concernant le jeu sont généralement indiqués dans le nom du fichier. Il s'agit d'une nomenclature particulière qui s'est imposée d'elle-même afin d'apporter des précisions utiles et importantes à la ROM et ainsi d'en faciliter son partage avec d'autres utilisateurs.

Émulation de haut niveau

L'émulation de haut niveau (HLE, High-Level Emulation) est une approche lors de la conception d'émulateur qui consiste à porter son attention sur la réponse du système émulé plutôt que sur le fait de recréer précisément son fonctionnement interne. Ce procédé s'oppose à la méthode traditionnelle d'émulation dite de bas niveau (LLE, Low-Level Emulation) dont l'objectif est d'imiter le comportement et le fonctionnement de la machine émulée.

Le critère permettant de définir un émulateur de haut niveau est plutôt simple : celui-ci doit posséder un niveau d'abstraction plus élevé que le code machine brut exécuté, niveau d'abstraction permis non pas par le logiciel exécuté par l'émulateur mais par son système d'exploitation ou son matériel.

Les avantages d'une émulation de haut niveau sont particulièrement importants dans le domaine de l'émulation des consoles de jeux de cinquième génération et plus : la complexité des consoles augmentant rapidement et leur architecture matérielle étant souvent assez éloignée de celle des PC, une émulation de bas niveau demanderait une puissance de calcul trop importante. À la place, l'émulation de haut niveau consiste à implémenter les fonctions requises par l'émulateur de façon appropriée pour la machine hôte, en tirant parti de ses caractéristiques matérielles : calcul en virgule flottante, GPU...

2.2.2. Acteurs

On peut noter la présence de différents acteurs selon les types d'émulateur que nous avons définis plus haut.

Émulateur de terminal - Virtualisation

On retrouve ici 5 acteurs principaux : VMware, Citrix, Microsoft, Sun et Parallels.

On retrouve ici 5 acteurs principaux : VMware, Citrix, Microsoft, Sun et Parallels.

Entreprise fondée en 1998, VMware a son siège à Palo Alto en Californie et possède des bureaux dans le monde entier. Sa clientèle est composée d'environ 170 000 sociétés de toutes tailles. Elle fournit des technologies conçues pour réduire sensiblement les coûts informatiques, élargir le choix de systèmes d'exploitation et offrir une infrastructure de systèmes plus automatisée et robuste, à même de s'adapter aux besoins fluctuants de l'entreprise.

Elle possède différentes solutions possibles, allant de la plus complète (Workstation) à une solution gratuite (Player).

C'est le leader sur le marché des logiciels de virtualisation.

Citrix Systems est une société de techniques avancées américaine basée à Fort Lauderdale, Floride, avec des filiales importantes au Royaume-Uni et en Australie. Elle était initialement uniquement éditrice de logiciels mais elle a acquis Net6 fin 2004 et propose désormais des solutions matérielles.

Citrix Systems est une société de techniques avancées américaine basée à Fort Lauderdale, Floride, avec des filiales importantes au Royaume-Uni et en Australie. Elle était initialement uniquement éditrice de logiciels mais elle a acquis Net6 fin 2004 et propose désormais des solutions matérielles.

Citrix propose une suite de produits proposant une architecture de fédération des applications, même hétérogènes. Dans leur architecture, les différentes applications de l'entreprise fonctionnent toutes sur un serveur centralisé. Les utilisateurs accèdent à leurs applications sur le serveur via un client Citrix.

Elle a acquis, le 15 août 2007, la société XenSource. Cela lui a permis d'entrer dans le marché de la virtualisation sur les serveurs et les stations de travail.

Microsoft Corporation est une multinationale informatique américaine, fondée par Bill Gates et Paul Allen. Son activité principale consiste à développer des systèmes d'exploitation et logiciels pour micro-ordinateur. Son siège social se situe à Redmond, près de Seattle, et ses meilleures ventes sont le système d'exploitation Windows et la suite bureautique Microsoft Office.

Microsoft Corporation est une multinationale informatique américaine, fondée par Bill Gates et Paul Allen. Son activité principale consiste à développer des systèmes d'exploitation et logiciels pour micro-ordinateur. Son siège social se situe à Redmond, près de Seattle, et ses meilleures ventes sont le système d'exploitation Windows et la suite bureautique Microsoft Office.

En octobre 2003, Microsoft a racheté le logiciel VirtualPC à l'entreprise Connectix pour pouvoir entrer dans le monde de la virtualisation.

Sun Microsystems est un constructeur d'ordinateurs et un éditeur de logiciels américain.

Sun Microsystems est un constructeur d'ordinateurs et un éditeur de logiciels américain.

Le 20 avril 2009, il est racheté par Oracle Corporation.

Le nom Sun vient de Stanford University Network (Réseau de l'Université Stanford). Il produit des serveurs et stations de travail basés sur le processeur SPARC et x86, les systèmes d'exploitation Solaris (anciennement SunOS), une Machine virtuelle Java, le langage de programmation Java.

Il développe l'environnement de virtualisation VirtualBox sous licence GPL.

Parallels est l'un des leaders mondiaux de logiciels de virtualisation et d'automatisation qui optimise l'infrastructure informatique des particuliers, entreprises et fournisseurs de services via toutes les plates-formes majeures de virtualisation, de systèmes d'exploitation et de matériel. Créée en 1999, Parallels est une société en croissance rapide qui compte environ 700 employés en Amérique du Nord, en Europe et en Asie.

Parallels est l'un des leaders mondiaux de logiciels de virtualisation et d'automatisation qui optimise l'infrastructure informatique des particuliers, entreprises et fournisseurs de services via toutes les plates-formes majeures de virtualisation, de systèmes d'exploitation et de matériel. Créée en 1999, Parallels est une société en croissance rapide qui compte environ 700 employés en Amérique du Nord, en Europe et en Asie.

On peut maintenant voir la répartition des forces sur le marché :

| Leader | Comptetitor | Follower | |

|---|---|---|---|

| VMWare | X | ||

| Citrix | X | ||

| Microsoft | X | ||

| Oracle VM (Sun) | X | ||

| Parallels | X |

Deux modifications majeures ont affecté le paysage des fournisseurs en 2007 et 2008 :

- l'acquisition de XenSource par Citrix ;

- la libération de Hyper-V de Microsoft.

En 2009, Microsoft est devenu un concurrent plus sérieux en partie à cause de la technologie Hyper-V mais aussi en raison du dynamisme de sa stratégie TI (Technologie de l'information) et de Virtual Machine Manager 2008. XenSource a été remplacé dans le paysage vendeur par Citrix (rachat). Parmi les trois fournisseurs figurant dans le paysage en tant que concurrents, Citrix est aujourd'hui le premier challenger de VMware en termes de largeur de produits et stratégie d'entreprise. Oracle est devenu aussi un concurrent sérieux depuis le rachat de Sun et de Virtual Iron.

En 2008, VMware a marqué son dixième année d'existence. Le premier produit de la société était un logiciel pour l'exécution de plusieurs instances virtuelles sur Microsoft Windows et sur les ordinateurs de bureau. Toutefois, il a mis en place des logiciels de virtualisation de serveur qui est devenu son produit phare. Grâce à cette longueur d'avance significative, VMware a acquis une part de marché dominante (plus élevé que 80% des installations selon certaines estimations). VMware a continué de croître et d'innover par la suite.

Mais 2008 n'a pas été une bonne année pour VMware. Les mouvements de la concurrence (par exemple Microsoft et Citrix) ont été beaucoup plus importants. On a également vu des turbulences internes et le président fondateur Diane Green et le cofondateur Mendel Rosenblum ont tous deux quitté l'entreprise. De plus, la société VMware a trébuché sérieusement en août 2008, quand une partie du code a causé la panne de la plus récente version d'ESX Server. Tous ces facteurs ont contribué à une baisse des prix des actions VMware.

Microsoft s'est positionné dans le domaine de la virtualisation depuis 2003 lors de l'acquisition de Virtual PC de Connectix. Toutefois, Microsoft ne pouvait pas prétendre être en concurrence directe avec VMware ESX Server, car il lui manquait un produit pour serveurs. Or, Microsoft n'a pas seulement mis en place l'hyperviseur Hyper-V, mais il a également lancé une initiative de marketing majeur autour de la virtualisation, qui comprend l'adoption de la notion de l'infrastructure publique dynamique (qu'il appelle Dynamic IT).

En 2008, la société Citrix a vendu tellement de solutions qu'elle a réorienté sa stratégie autour de la virtualisation.

En terme de qualité du produit et de l'entreprise, on obtient le tableau suivant :

| Maturité du produit et de la firme | Fonctionnalités avancées et pertinence pour les infrastructures de services publics | Coût de la licence | |

|---|---|---|---|

| VMWare | Haute | Haute | Basse |

| Citrix | Moyenne | Haute | Moyenne |

| Microsoft | Moyenne | Basse | Moyenne |

| Oracle | Moyenne | Moyenne | Haute |

On peut donc voir que le leader du marché est VMware mais que les concurrents se rapprochent de lui petit à petit en proposant des améliorations de leurs produits et en mettant en place des stratégies de communication de plus en plus agressive.

Émulateur électronique

Nous n'avons pas trouvé beaucoup d'acteurs dans ce domaine. En effet, d'après nos recherches, il semblerait que les entreprises préfèrent développer leur propre solution car elle ne trouve exactement ce qu'elles recherchent sur le marché. Pour preuve, on peut prendre le cas de Renault qui souhaitait uniformiser ses outils de test des systèmes électroniques embarqués dans ses véhicules. Comme elle ne trouvait pas de solution commerciale répondant à ce besoin, le constructeur français a confié à la société Clemessy le développement d'une solution logicielle capable de piloter les tests tout le long du cycle de conception.

C'est comme cela que s'est mise en place la solution de Renault : TestInView. C'est un logiciel pour le pilotage des tests de validation de systèmes électroniques embarqués conçu pour une utilisation dans toutes les phases de test du processus de développement et de validation (depuis la représentation virtuelle sous forme de modèles numériques vers son implémentation physique définitive en passant par des stades intermédiaires mixtes et par les différentes versions de maturation des prototypes).

Mais nous avons tout de même trouvé 2 acteurs : dSpace et National Instruments.

Depuis sa création en 1998, dSPACE s'est considérablement développé. En plus de son siège à Paderborn, en Allemagne, ses centres de projets près de Munich et de Stuttgart offrent sur place un support optimal à ses clients. La société est représentée à Detroit, aux États-Unis (depuis 1991), à Melbourn au Royaume-Uni (depuis 2001), à Bièvres en France (depuis 2001), à Tokyo au Japon (depuis 2006) et à Shanghai en Chine (depuis 2008).

Depuis sa création en 1998, dSPACE s'est considérablement développé. En plus de son siège à Paderborn, en Allemagne, ses centres de projets près de Munich et de Stuttgart offrent sur place un support optimal à ses clients. La société est représentée à Detroit, aux États-Unis (depuis 1991), à Melbourn au Royaume-Uni (depuis 2001), à Bièvres en France (depuis 2001), à Tokyo au Japon (depuis 2006) et à Shanghai en Chine (depuis 2008).

Il y a vingt ans, elle fut pionnière et attirait déjà beaucoup l'attention. Elle a posé les fondations de technologies clés telles que celles du prototypage rapide de lois de commande et de la simulation Hardware-in-the-Loop.

National Instruments fut fondé en 1976 par le docteur James Truchard, Bill Nowlin et Jeff Kodosky. Elle possède son siège à Austin (Texas) et a plus de 5 000 employés et a des activités dans 41 pays. Depuis 10 ans (1998-2008), le magazine Fortune considère National Instruments comme l'une de 100 meilleures entreprises aux États-Unis.

Elle produit des logiciels d'instrumentation virtuelle. Ceux-ci comprennent l'environnement de développement graphique LabVIEW, l'environnement de développement LabWindows, Measurement Studio pour l'instrumentation sous .NET, le séquenceur de tests TestStand et des matériels modulaires tels que les modules PXI pour l'acquisition de données, le contrôle des instruments et la surveillance des machines.

Émulateur de jeux

En ce qui concerne les émulateurs de jeux, les acteurs sont nombreux et beaucoup de regroupements de développeurs (des "teams") se sont créés pour pouvoir mettre au point des émulateurs de console afin de permettre au plus grand nombre de pouvoir jouer.

2.3. Simulation

2.3.1. Open Source Physics

OSP est un projet sponsorisé par la NSF (National Science Foundation) dont l'objectif est de distribuer des outils et des bibliothèques logicielles libres pour la physique et la simulation numérique. Il inclut l'outil EJS (Easy Java Simulations) qui permet la création de simulations sur ordinateur en les décrivant au niveau mathématique plutôt qu'avec du code source.

2.3.2. Les solutions

Il existe un grand nombre de logiciels de simulation, particulièrement dans le domaine de la mécanique des fluides et des gaz (dispersion…), du comportement de structures, des mouvements ou des collisions.

Dans ces domaines, on peut citer les logiciels européens suivants :

- Code Aster, Code Mascaret et Code Saturne, du service R&D d'EDF

- Thétis, d'un laboratoire de l'université de Bordeaux

- PHAST, de la société norvégienne DNV

- SAMCEF, d'un laboratoire de l'université de Liège

- AnyLogic, de la société russe XJ Technologies.

D'autres logiciels sont dédiés à la simulation de problèmes de gestion industrielle et de logistique : ligne de production, distribution, transports... :

- FlexSim, de la société américaine FlexSim Software

- Renque, de la société hollandaise homonyme

- Plant Simulation, de Siemens PLM Software.

Une liste plus importante peut être consultée dans la partie "exemple de logiciels" de l'article "simulation informatique" de Wikipédia : http://fr.wikipedia.org/wiki/Simulation_informatique, ou sur son équivalent anglophone: http://en.wikipedia.org/wiki/List_of_computer_simulation_software.

Nous allons maintenant détailler quelques solutions plutôt répandues ou d'usage assez général.

Plant Simulation

Licence : commerciale

Licence : commerciale

Systèmes d'exploitation : Windows

Développeur : Siemens

Plant Simulation est un logiciel pour la modélisation, la simulation, l'analyse, la visualisation et l'optimisation de systèmes et processus de production, et les opérations logistiques.

Le logiciel supporte la programmation orientée objets, y compris l'héritage et le polymorphisme. Il est possible d'importer des données depuis d'autres solutions telles qu'Oracle, Access, Excel ou SAP, ainsi que des dessins créés avec AutoCAD ou Microstation par exemple.

La solution vient avec plusieurs outils permettant la détection de goulots d'étranglement (Bottleneck Analyzer), le suivi de flux de matériel (diagrammes de Sankey) et la détection de ressources surdimensionnées.

Les outils d'analyse de données comprennent aussi des algorithmes génétiques, des réseaux neuronaux, des analyses régressives, des détections de dépendances etc.

Code-*

Licence : libre (GNU/GPL)

Licence : libre (GNU/GPL)

Systèmes d'exploitation : multiplateforme (Fortran, Python, Java)

Développeur : EDF

Code Saturne, Code Mascaret et Code Aster sont les noms de trois projets développés par la section Recherche et Développement d'EDF depuis les années 80. Ils sont placés sous une licence open source depuis quelques années.

- Code Aster est un logiciel de simulation numérique (Analyse des Structures et Thermomécanique pour les Études et des Recherches) développé au départ pour répondre aux besoins internes d'EDF. Le coeur du système est développé en Fortran, et les modules complémentaires en Python. C'est principalement un solveur basé sur la théorie de la mécanique des milieux continus (déformation des solides, écoulement des fluides…) qui permet de résoudre des problèmes mécaniques, thermiques, acoustiques, sismiques, etc. ;

- Code Mascaret est également un logiciel de simulation numérique. Il est davantage axé sur la modélisation hydraulique monodimensionnelle. La description officielle est la suivante :

Le logiciel Mascaret est composé de trois noyaux de calcul hydrodynamique et permet des calculs en régime :

- fluvial permanent et non permanent

- transcritique non permanent

- propagation de crues et modélisation des champs d'inondations,

- onde de submersion résultant de la rupture d'ouvrages hydrauliques,

- régulation des rivières aménagées,

- propagation d'onde dans les canaux (intumescences, éclusées, mise en eau).

- Code Saturne, également spécialisé dans la simulation numérique et la mécanique des fluides, permet de modéliser les écoulements incompressibles et dilatables, avec ou sans turbulence ou transfert de chaleur. Il peut être associé au code de mécanique des structures de Code Aster.

AnyLogic

Licence : commerciale

Licence : commerciale

Systèmes d'exploitation : multiplateforme (Java)

Développeur : XJ Technologies

AnyLogic est un outil de simulation possédant un langage de modélisation graphique facilement extensible. Il inclut les bibliothèques standards suivantes :

- La bibliothèque d'entreprise permet la simulation dans les domaines de la fabrication, des chaînes d'approvisionnement, de la logistique et de la santé grâce à des modèles de systèmes en termes d'entités, de processus et de ressources ;

- La bibliothèque piétonne permet de simuler des flux piétons dans des environnements « physiques » : stations de métro, contrôles de sécurité, rues… Les piétons sont simulés comme des agents interagissant avec des comportements complexes ;

- La bibliothèque de chantier supporte la modélisation, la simulation et la visualisation des opérations d'un chantier de triage ferroviaire. Les modèles peuvent ensuite être combinés avec des modèles SMA (Systèmes Multi-Agents) ou évènements discrets (activités de transport…).

2.3.3. Les acteurs

Nous allons passer en revue quelques acteurs dans le domaine de la simulation.

EDF

Électricité de France est la principale entreprise de production et de distribution d'électricité en France. Elle a été créée en 1946, et s'est attachée par la suite à standardiser la tension fournie à ses clients, pour arriver au 230 V monophasé et 230/400 V triphasé.

Électricité de France est la principale entreprise de production et de distribution d'électricité en France. Elle a été créée en 1946, et s'est attachée par la suite à standardiser la tension fournie à ses clients, pour arriver au 230 V monophasé et 230/400 V triphasé.

Si EDF n'est pas fondamentalement une entreprise spécialisée dans l'informatique et le développement de logiciels, son département Recherche et Développement a contribué à plusieurs projets en rapport avec la simulation numérique : en plus de Code Aster, Code Saturne et Code Mascaret dont nous avons déjà parlé, EDF a contribué à la plate-forme Salomé qui offre différents services génériques pour la réalisation d'études et de simulations.

Siemens

Siemens est une entreprise allemande, également le plus gros conglomérat européen. Fondée en 1847 par Werner von Siemens, la société était à l'origine spécialisée dans la télégraphie. Elle possède maintenant plus de 430 000 employés, et un chiffre d'affaires de 100 milliards d'euros en 2008.

Siemens est une entreprise allemande, également le plus gros conglomérat européen. Fondée en 1847 par Werner von Siemens, la société était à l'origine spécialisée dans la télégraphie. Elle possède maintenant plus de 430 000 employés, et un chiffre d'affaires de 100 milliards d'euros en 2008.

En janvier 2007, Siemens a acquis la société de développement texane UGS et l'a renommée « Siemens PLM Software ». Celle-ci est spécialisée dans les logiciels 3D et les solutions PLM (Product Lifecycle Management, littéralement « gestion de cycle de vie du produit »). Ses produits phares sont NX, un logiciel de CAD, la suite Teamcenter pour le design et développement de produits et la collaboration, et Tecnomatix, une suite d'outils pour la gestion de production.

XJ Technologies

XJ Technologies est une société fondée en 1992 à St Petersburg en Russie. L'entreprise a depuis développé deux nouvelles branches spécialisées dans la vente et les conseils : une dans le New Jersey aux États-Unis, et une à Paris. AnyLogic est apparemment la seule solution que la société maintient actuellement.

XJ Technologies est une société fondée en 1992 à St Petersburg en Russie. L'entreprise a depuis développé deux nouvelles branches spécialisées dans la vente et les conseils : une dans le New Jersey aux États-Unis, et une à Paris. AnyLogic est apparemment la seule solution que la société maintient actuellement.

2.4. Sources

- HIL : http://leadingedgeinnovations.biz/EmbeddedSystemProgramming/files/99/9902/f-ledin.pdf

- dSpace : http://www.dspace.fr/ww/fr/fra/home.cfm

- NI : http://www.ni.com/

- Données sur les marchés :

- Zdnet : http://www.zdnet.fr/

- Vmware : http://www.vmware.com/fr/

- Citrix : http://www.citrix.fr/

- Introduction à la synthèse logique : ftp://ftp.discip.crdp.ac-caen.fr/discip/crgelec/Cours/vhdl.pdf

- Émulation de haut niveau : http://en.wikipedia.org/wiki/High-level_emulation

- Code Aster : http://www.code-aster.org/V2/spip.php?rubrique1

- Code Mascaret : http://innovation.edf.com/recherche-et-communaute-scientifique/logiciels/code-mascaret-41197.html

- Présentation d'AnyLogic : http://www.anylogic.fr/anylogic/why_anylogic/

Formations en informatique et multimédia

En informatique, l’école d'ingénieurs est la voie royale. Mais de nombreuses formations courtes ont excellente réputation, à l’exemple des BTS (Brevets de Technicien Supérieur) informatique de gestion, BTS informatique et réseaux pour l’industrie et les services techniques et des DUT (Diplômes Universitaires de Technologie) informatique, DUT GEII (génie électrique et informatique industrielle) et réseaux et télécommunications.

Côté multimédia, en 2 ans après le bac, on peut citer, pour les futurs techniciens, les DUT services et réseaux de communication, et DUT informatique ; pour les futurs créatifs, le BTS communication visuelle, option multimédia. À l’université, il existe de très nombreuses licences pros et des masters pros liés à l’informatique et aux télécoms, notamment en ingénierie de l’information, spécialité multimédia. Des écoles d’art appliqué et des écoles d'ingénieurs, ainsi que des établissements spécialisés délivrent des formations en création ou au multimédia.

Concernant la formation de concepteurs de jeux vidéo, il n’existe pas de parcours type. Un BTS communication visuelle option multimédia peut être une première voie. Mais la tendance est à la hausse des qualifications. Plusieurs cursus offrent des formations appréciées par le métier : Supinfogame à Valenciennes, les Gobelins-l’École de l’image à Paris, le master pro jeux et médias interactifs numériques de l’ENJIM d’Angoulême et des universités de Poitiers et de La Rochelle.

Pour être infographiste 3D, il existe des écoles spécialisées, telles Supinfocom et Supinfogame à Valenciennes. On peut aussi passer par des écoles d’art qui ont intégré des cours d’infographie dans leur cursus (les Gobelins, l’ENSAD).

Aspect Marketing

3.1. Introduction

Le marketing industriel se définit comme le marketing en direction des professionnels ou des organisations par opposition au marketing de grande consommation, qui s'adresse au grand public. Les produits ou services achetés par les entreprises, les collectivités ou les administrations publiques sont utilisés directement ou indirectement à la production d’autres produits ou services. Il se compose de toutes les organisations qui acquièrent des biens et services en vue de produire d'autres biens et services fournis à autrui.

Le chiffre d'affaires des échanges commerciaux entre les entreprises représente près de 70 % de l'ensemble des échanges commerciaux. Il est donc plus important que celui réalisé sur le marché des particuliers. C'est l'utilisation du produit plutôt que sa nature qui distingue le bien industriel du bien de consommation. Le marketing industriel se définit donc par apport aux marchés non par rapport aux produits ou services.

Le marketing industriel emprunte au marketing classique un certain nombre de techniques en les adaptant aux caractéristiques propres de ce type de marché et en utilisant des outils plus spécifiques pour atteindre les objectifs.

Il est nécessaire d’adapter l’approche commerciale à chaque marché cible. Il faut une synergie entre la force de vente et le marketing. Il faut, en outre, une meilleure analyse des besoins de la clientèle. Enfin, il faut un développement des relations publiques. On passe donc d’une approche tactique à une approche stratégique.

3.2. Caractéristiques du marketing industriel

En marketing industriel, la demande est le fruit de la demande d’autres produits ou services. Par exemple, la demande d’emballage pour produits alimentaires dépend du produit alimentaire lui-même.

Les clients se comptent souvent en dizaines même parfois en milliers mais rarement plus. D’où le risque de dépendance exagérée clients / fournisseurs.

En général le produit est plus complexe, mais surtout, il s’accompagne fréquemment d’assistance (installation, entretien, réparation), ou de fourniture de produits ou services complémentaires (ex : informatique, aéronautique...).

Le client est souvent dépendant de son fournisseur pour :

- la régularité des livraisons

- la constance de la qualité

Le client a donc besoin du fournisseur et le fournisseur a besoin du client. C’est une relation durable, il y a un climat de confiance et donc cette relation s’entretien.

Toutes les fonctions de l’entreprise interagissent dans le processus de décision, plus qu’en marketing de grande consommation. Il y a une corrélation certaine entre la vente (prévisions, affaires en cours, évaluation du potentiel…) et le marketing. Le vendeur est un partenaire marketing plus qu’un exécutant.

Pour finir, ici, pas d’achat spontané comme c’est souvent le cas pour le consommateur. L’achat est dans le cas présent calculé et influencé par de très nombreux intervenants (finances, production, conseil, achat).

3.3. Complexité de l’échange industriel

3.3.1. Côté client (achat)

La situation d’achat est importante. Les types d’achat sont :

- L’achat nouveau : c’est un nouveau fournisseur, il faut donc comprendre ses besoins, avoir un maximum d’informations et créer un climat de confiance.

- L’achat identique : le client est connu. Le marketing s’attache à se repositionner tout le temps comme partenaire. Il faut donc utiliser un marketing d’entretien pour que le client se rappelle.

- L’achat modifié : le client a déjà acheté, mais il renouvelle son achat qui est un peu différent. Ce qui va compter, c’est l’offre du fournisseur.

3.3.2. Côté vendeur (vente)

Il existe différents types de clients :

- Les intégrateurs : il s’agit d’incorporer des matières premières dans le processus de production. A nouveau, il faut établir une relation durable entre fournisseurs et clients.

- Les utilisateurs : on intègre des éléments (machines, gaz, eau, électricité, étiquetage…) au système de production et non au produit. Il faut établir une relation durable avec le fournisseur (ex : informatique).

- Les distributeurs : cela correspond au trade marketing.

3.4. La communication

Il faut au préalable déterminer la cible. En effet, la question qui se pose est : Est-ce que mon produit s’adresse à des clients directs (Stratégie PUSH) ou est-ce qu’il s’adresse à des utilisateurs finaux (Stratégie PULL). En général il s’agit d’un mélange des deux, il faut donc adapter les deux stratégies précédemment citées en proportionnellement à l’objectif de la société. Prenons l’exemple de Gore-Tex, le produit est incorporé à la production de produits et ils font de la publicité pour le client final alors qu’ils ne leur en vendent pas directement. Le consommateur va acheter par exemple des produits ‘aigle’, car il y a du Gore-Tex dedans et qu’on retrouve le label.

3.5. Les moyens

3.5.1. Les moyens personnalisés

Le vendeur est l’un des vecteur essentiel de l’information concernant les faits, car même si cette information est aussi transmise par d’autres moyens (catalogues, etc.), il peut, le mieux, la personnaliser en fonction des attentes du client.

Le vendeur à plusieurs rôles :

- la vente elle-même : trouver le besoin et les motivations du client et traduire ce besoin dans l’entreprise.

- Il doit véhiculer une image de l’entreprise

- Le vendeur remonte l’information sur le marché : quand il a une information sur les concurrents, il la retient et la remonte dans la société.

3.5.2. Quelques moyens directs de contact

- Foires et salons : Il y a des foires spécialisées dans différents secteurs et ce sont des lieux privilégiés pour connaître ses concurrents (clients fantômes). Au cours de ces évènements, il faut faire les démonstrations, se faire connaître, vendre, voir la concurrence, prendre des contacts...

- Publicité directe : (= marketing direct) : mailings, envois personnalisés pour annoncer un nouveau produit, pour suivre des formations...

- Démonstration : normalement, on prend le matériel avec soi, on fait la démonstration et on vend. Quand ce n’est pas possible, on emmène le client potentiel chez un autre client ou chez soi pour lui montrer comment ça fonctionne et le lui expliquer. Sinon, il est possible de montrer d’une autre façon son produit au client. En effet, grâce aux nouvelles technologies, on peut désormais faire des démonstrations sur prototype virtuel plutôt que physique. Cela a pour avantages de limiter les coûts de transports de prototypes parfois imposants et de montrer de l’entreprise une image innovante.

- Séminaires de formation et d’informations : si par exemple, on introduit un nouveau produit en peinture, on invite le client à venir voir le nouveau produit et l’on fait une conférence pour tout expliquer. Cela renforce la fidélisation et crée des liens entre les parties.

- Les relations publiques internes et externes : le but est d’informer les différents publics (presse, gouvernement, fédération, associations…) sur une vision positive de l’entreprise

3.5.3. Les moyens indirects de contact

- Publicité produit (publicité pour mettre en avant le produit)

- Publicité institutionnelle (publicité pour mettre en avant le nom de l’entreprise)

3.6. Résumé des outils de communication

| La publicité | La promotion des ventes | Les relations publiques | La vente |

|---|---|---|---|

| Messages presse, radio, télévision et cinéma | Jeux et concours | Dossiers de presse | Démonstrations |

| Mailing | Loteries | Communiqués | Réunions de vente |

| Catalogue | Primes | Séminaires | Salons et foires |

| Prospectus (Imprimé sans adresse) | Échantillons | Rapport annuels | |

| Journaux internes | Stands | Mécénat | |

| Annuaires | Bons de réductions | Parrainage (sponsoring) | |

| Affiches | Coupons | ||

| Présentoirs (Publicité sur le lieux de vente) | Remises | ||

| Symboles et logos | Animation podium |

Le plus souvent, les entreprises mélangent plusieurs de ces moyens dans leur stratégie marketing.

3.7. Les arguments de vente

Enfin, certains arguments peuvent être avancés lors d’une vente afin d’aboutir à une conclusion positive de la transaction. On peut notamment mettre en avant les points suivants :

- les normes ISO (cela signifie que le processus de production répond à certaines normes)

- fiabilité du service après vente

- les brevets

3.8. Conclusion

En conclusion, l’utilisation d’un logiciel de simulation 3D constitue un outil de communication dans le domaine de la vente. Il peut constituer l’outil central de la stratégie, mais sera accompagné d’autres outils, que ce soit dans le domaine de la publicité ou des relations publiques.

Un logiciel de simulation pourrait être utilisé dans le cadre d’une stratégie de marketing virtuel qui est un mix entre la 3D, la communication et le marketing. Les principales stratégies de ce type de marketing sont la notoriété, l’image et le relationnel. La notoriété peut être mise en place au travers du Buzz marketing ou de la publicité virtuelle. Certaines sociétés investissent le milieu de la simulation virtuelle sociétale tel que Second Life pour renforcer leur image innovante et dynamique. Enfin cela permet d’établir une relation peut-être plus étroite entre l’entreprise et son marché cible.

On se dirige maintenant vers le marketing 2.0. Ce marketing est centré sur l’utilisation du Web 2.0. Il emploie des supports divers tels que les blogs, les flux RSS, les wikis, les réseaux sociaux ou de façon plus large tout ce qui constitue le web participatif ou communautaire dans la communication marketing d'une marque ou institution. Les marques et institutions peuvent soit :

- exploiter les espaces de socialisation existants pour la cible marketing concernée.

Cela revient à intervenir sous la forme d'individus inscrits sur ces espaces: blogs, wikis et réseaux sociaux. Les marques et institutions créent entre autres leur groupe sur Facebook ou Myspace. - créer leurs propres espaces de socialisation pour leurs publics.

En définitive, le marketing 2.0 est une réelle mutation du monde du marketing. Il constitue en effet une réponse aux diverses préoccupations des consommateurs, tant au niveau de la saturation publicitaire que de l’essoufflement du marketing traditionnel. Il apporte aussi des éléments de réponses aux professionnels, toujours en quête d’une meilleure efficacité. C’est l’apparition du Web2.0 qui a offert de nouveaux usages et donc une transposition au monde du marketing. Or on évoque déjà le terme de Web 3.0. Cela laisse entrevoir l’idée d’une nouvelle évolution conséquente du Web qui pourrait à son tour avoir des répercussions sur le marketing comme le Web 2.0 en a déjà eu.

Version PDF

Version PDF